Le anomalie di temperatura media mondiale terra+oceano (GHCN-M 3.2.0) scaricabili da qui sono state aggiornate con i dati relativi ai mesi di febbraio, marzo, aprile 2013. Si può trovare una descrizione dell’aggiornamento precedente (gennaio 2013) qui. I grafici e i dati numerici sono disponibili, mese per mese, qui dove tutti i confronti vengono fatti rispetto ad agosto 2012, cioè dall’inizio della versione 3.2.0.

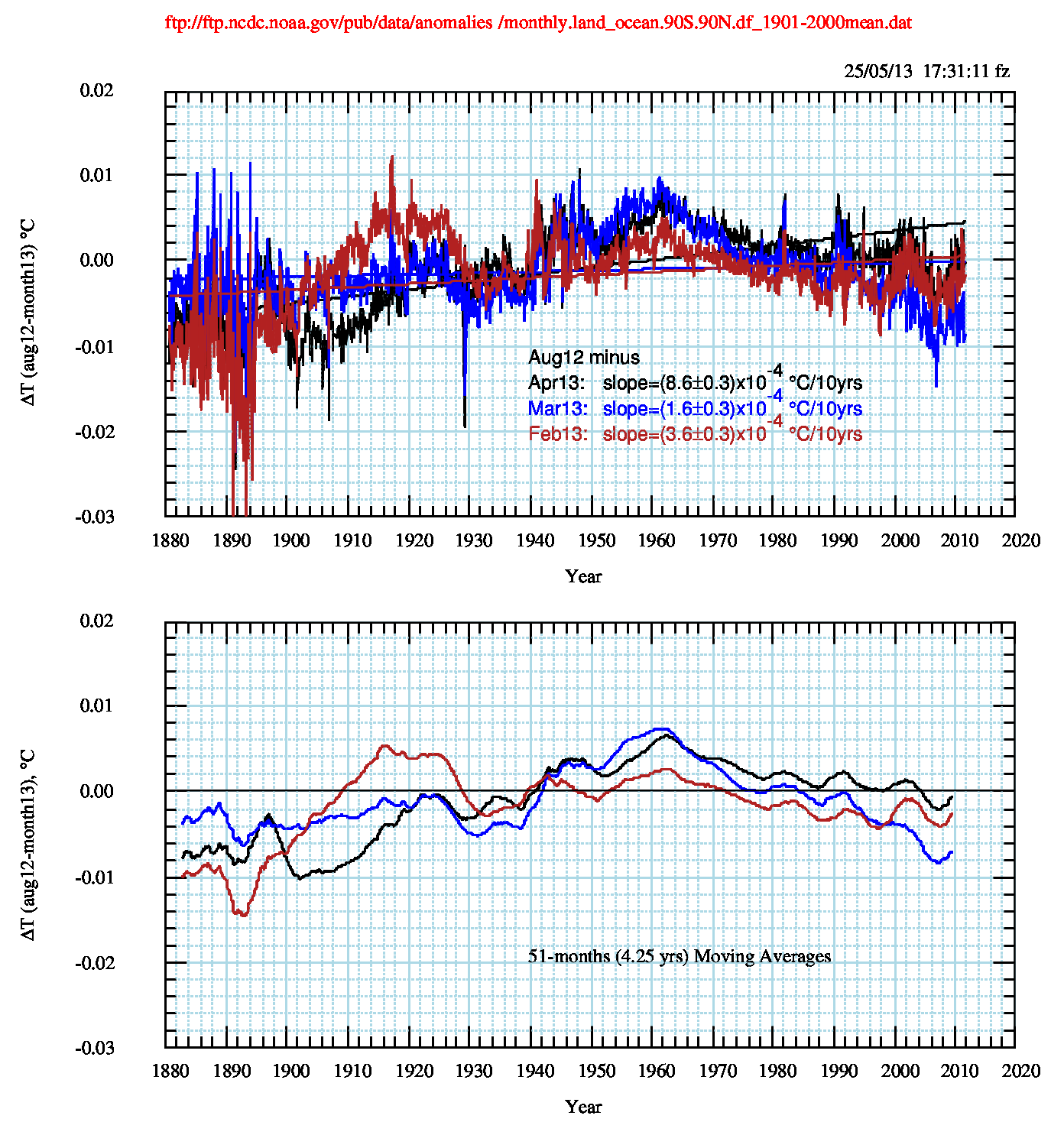

La differenza di anomalia tra agosto ’12 e i tre mesi di cui si occupa questo post (pdf) è:

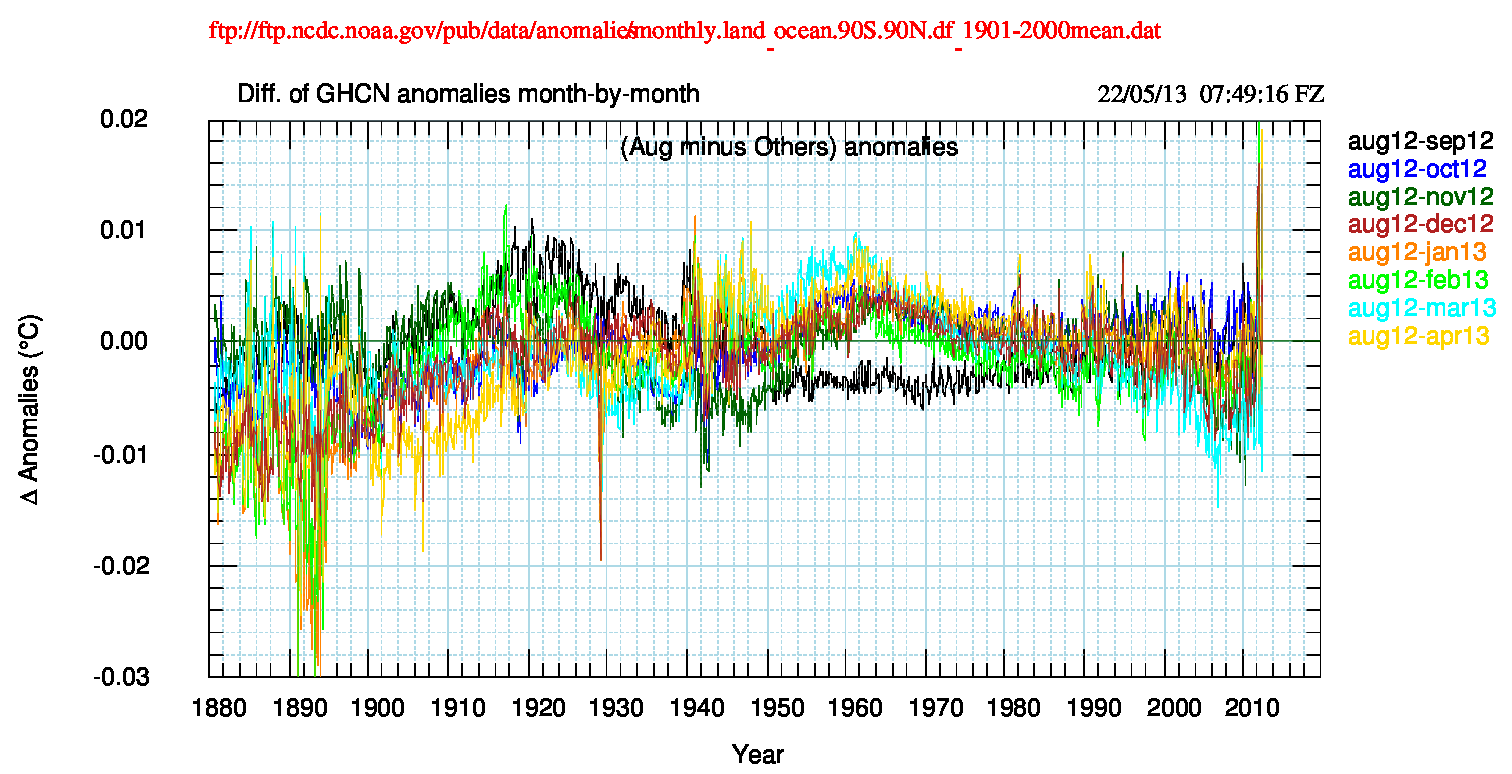

La Fig.2 (pdf) mostra che complessivamete le correzioni tendono a raggrupparsi entro l’intervallo ±0.01°C.

Tra il 1890 e il 1896, invece, le “osservazioni” (ricordiamo che sono sempre il risultato del processo di omogenizzazione che viene applicato ogni mese all’intero dataset storico, come descritto nel Technical Report version 3.2.0 che si può visualizzare da qui) continuano a mostrare un forte discostamento, superiore a 0.03 °C.

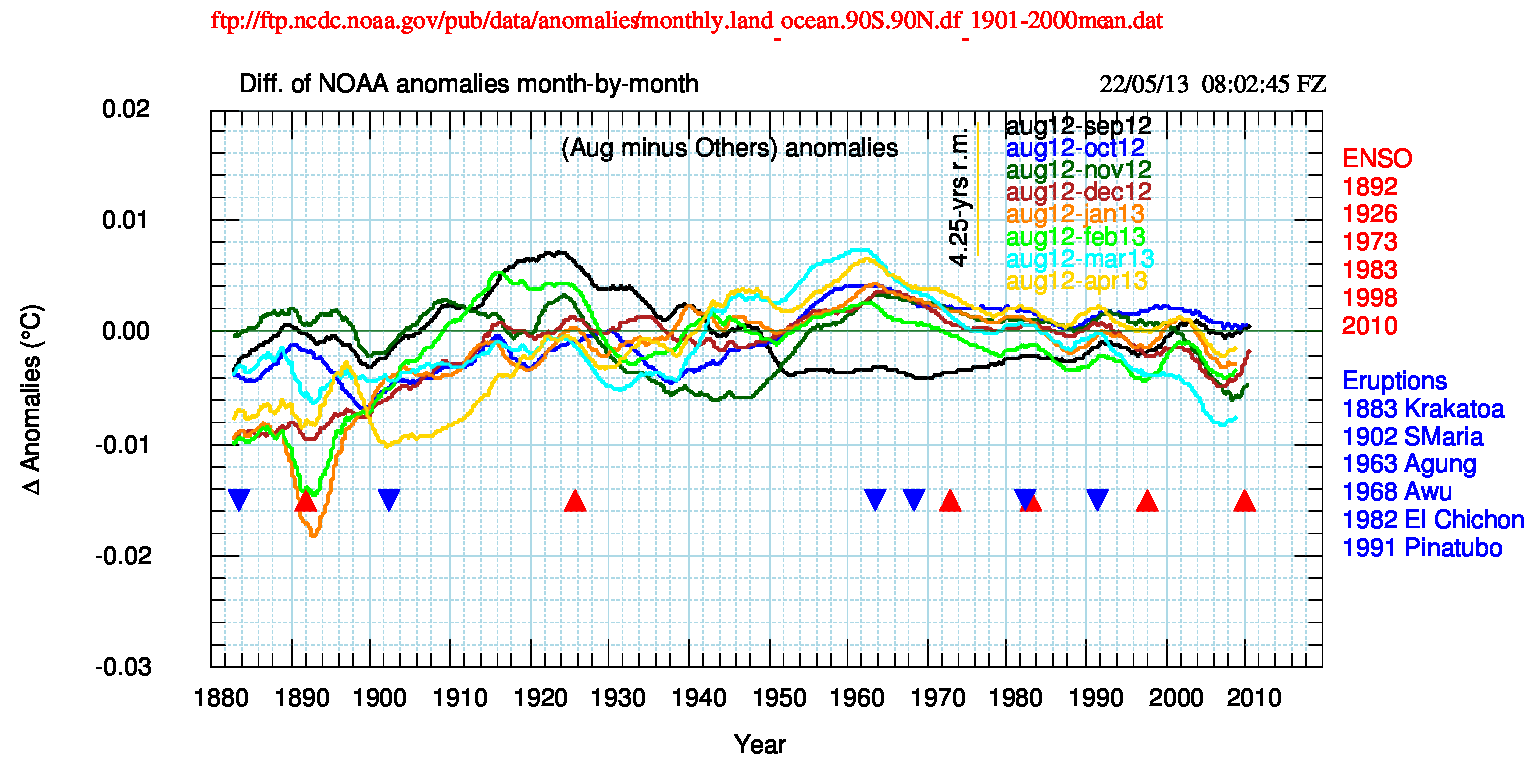

La Fig.3 (pdf), che usa la media mobile dei dati di Fig.2, mostra ancora che le differenze sono sistematicamente entro limiti più che accettabili, a parte i primi venti anni del dataset, e che le procedure hanno raggiunto una buona stabilizzazione, confermando la scelta di pubblicare le variazioni ogni tre mesi. Continuerò a raccogliere i dati mensili e a calcolare le variazioni dei parametri, pronto a pubblicare ogni variazione significativa. I dati dei singoli mesi saranno disponibili nel sito di supporto qui.

La Fig.4 (pdf) mostra la media mobile delle differenze tra le anomalie di agosto ’12 e aprile ’13. Ancora una volta si vede che i dati di aprile, nella parte iniziale del dataset, sono sistematicamente “più freddi” fino al 1930 per poi diventare sistematicamente “più caldi” dal 1944 ad oggi.

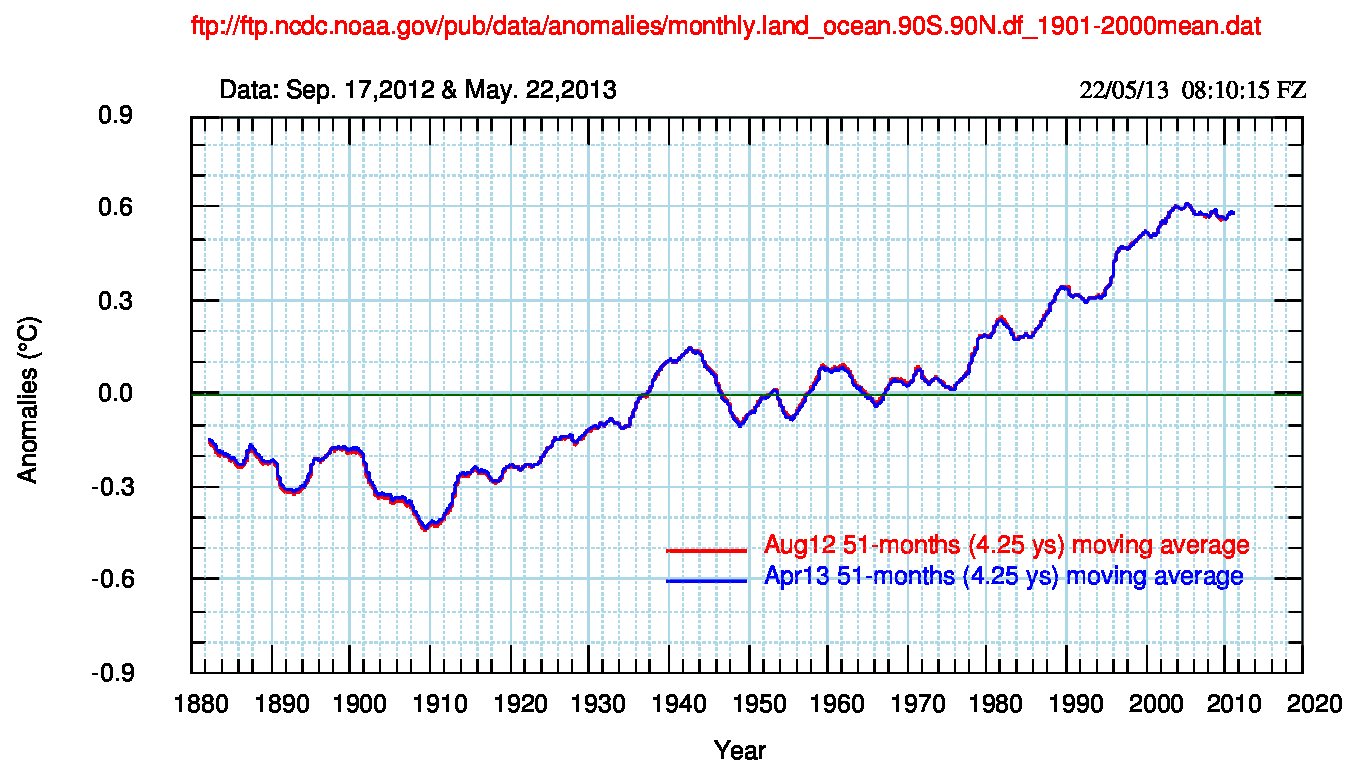

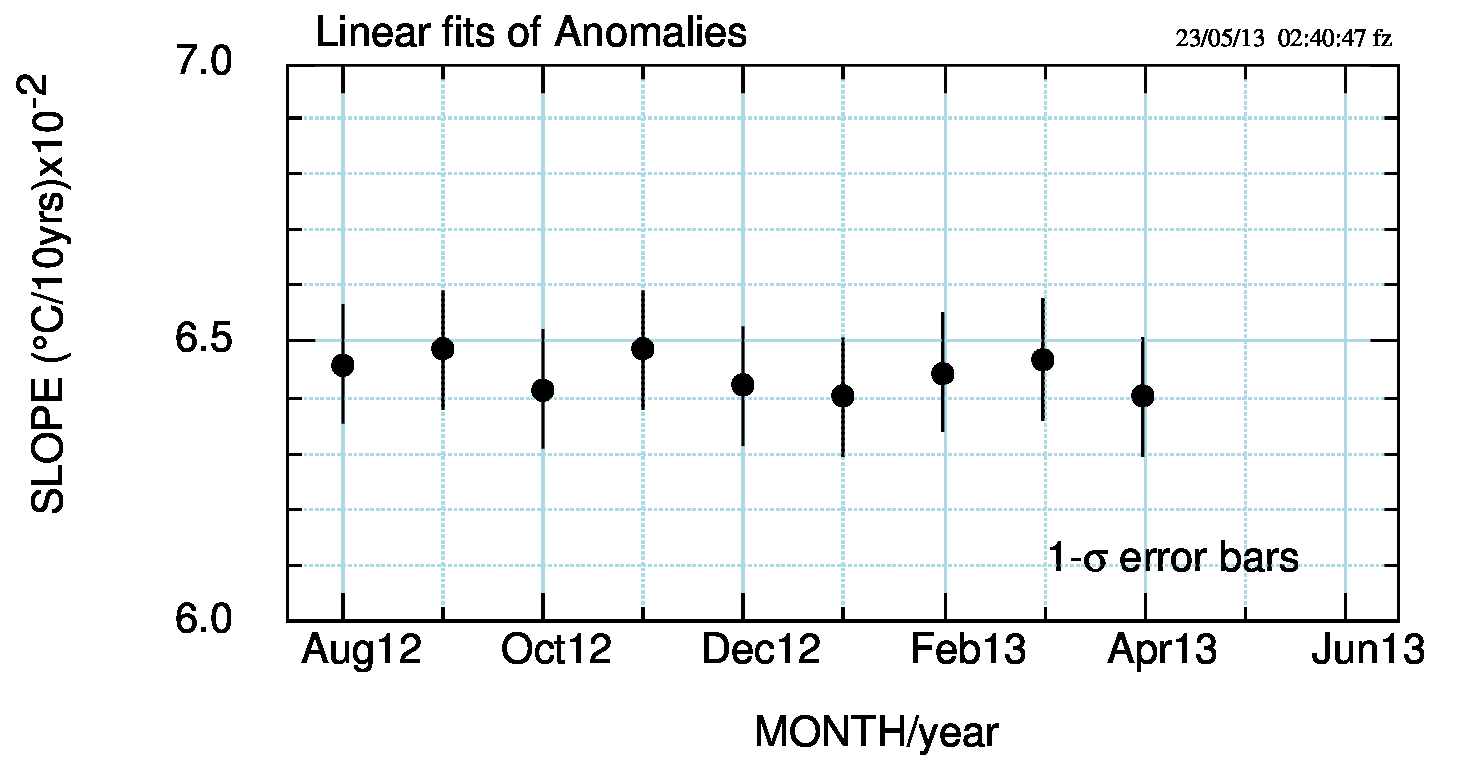

Nella Fig.5 (pdf) rappresento le pendenze delle anomalie (cioè dei dati originali). Per ora, e considerando gli errori, non ci sono variazioni significative.

Per gli spettri viene ancora mantenuta la storia precedente all’entrata in vigore della versione 3.2.0, perché è presente una continuità che attraversa le versioni successive di GHCN. Solo il massimo a 265-266 anni – di cui bisogna sottolineare la poca (o nulla) rappresentatività, essendo disponibile un dataset di poco più di 132 anni – ha un brusco salto tra luglio e agosto 2012 (inizio della vers. 3.2.0), con la potenza che cresce del 16%, passando da 77.5 a 92 unità.

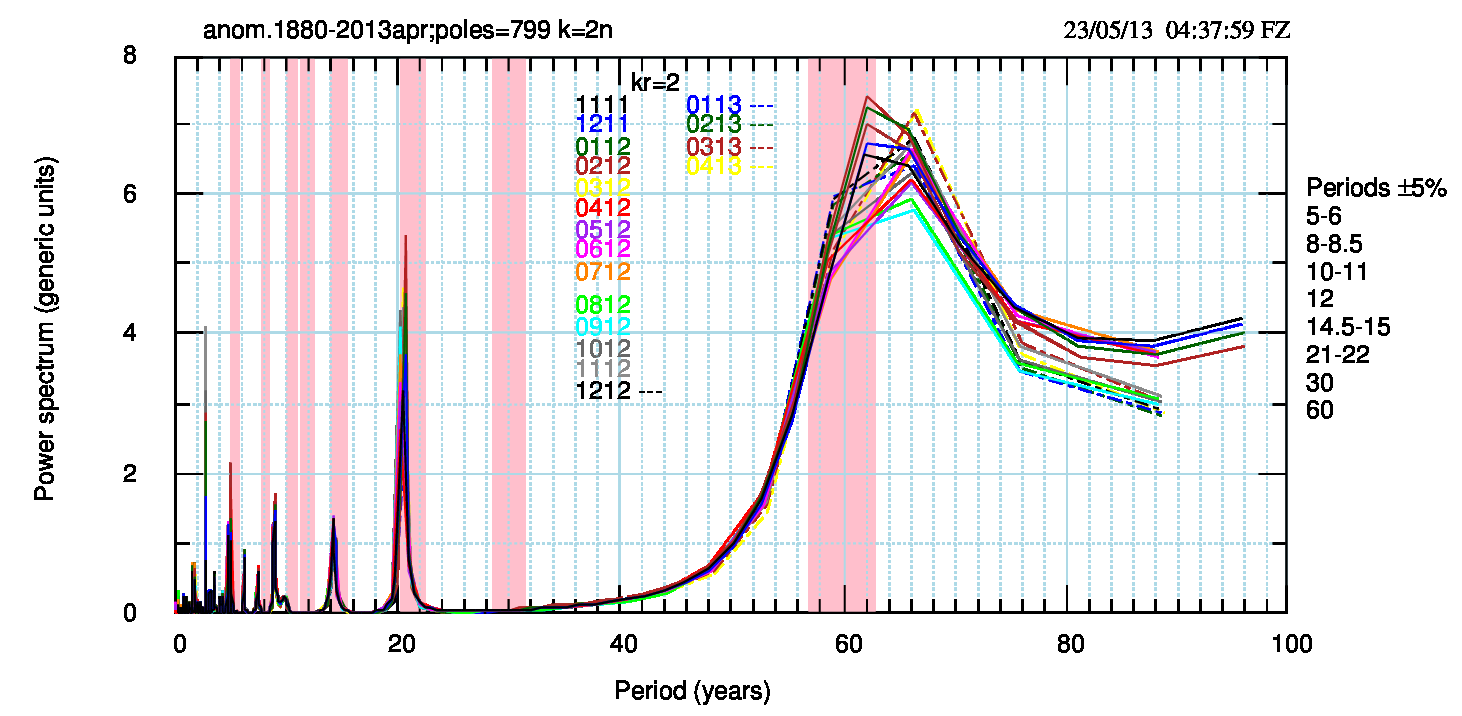

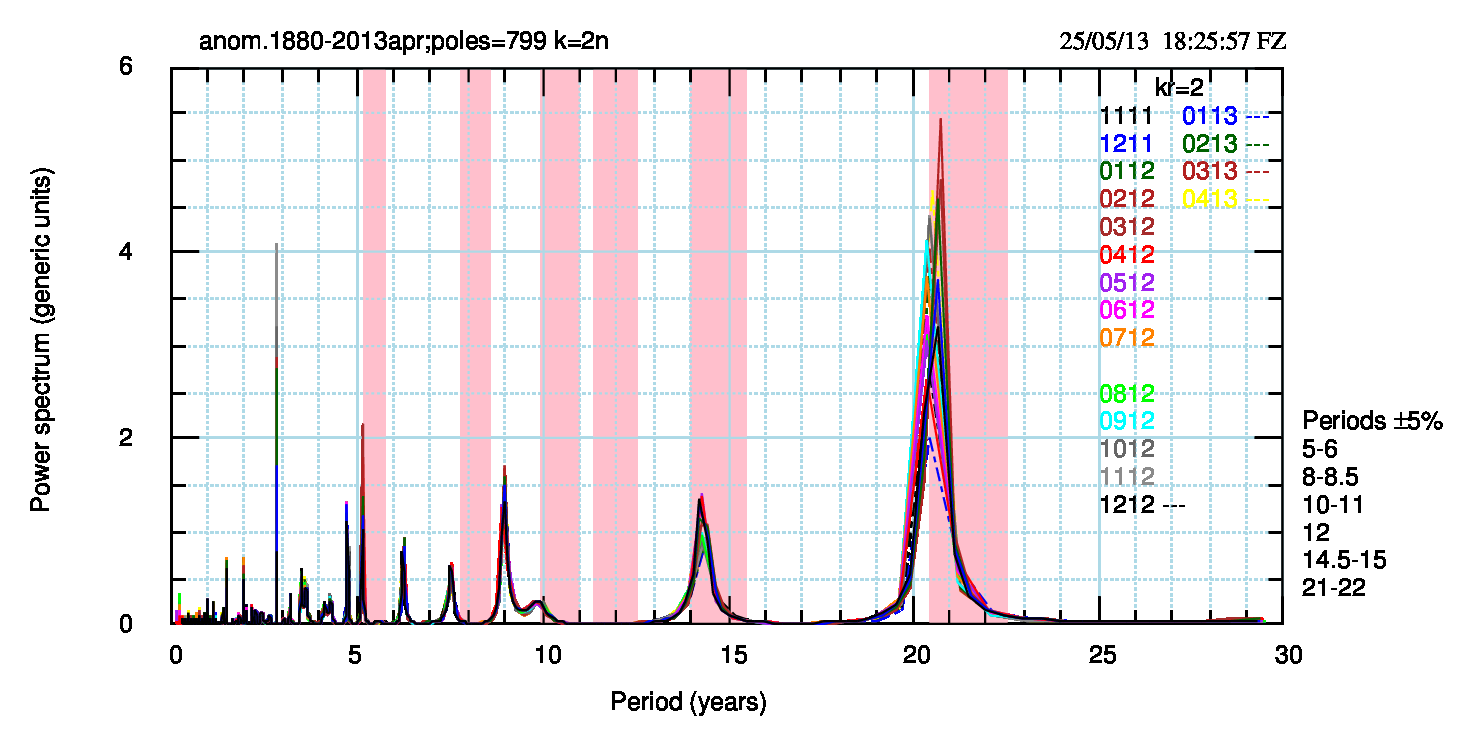

Gli spettri di potenza dei 18 dataset mensili disponibili vengono mostrati nella successiva Fig.6 (pdf) e nell’ingrandimento della sua parte sinistra (Fig.7, pdf).

Nelle Figg. 6 e 7 sono presenti per confronto i periodi (che chiamo “astronomici”), legati alle interazioni tra Sole e pianeti, elencati in Scafetta (2010) (pdf) e in Scafetta (2012) (pdf), osservati in altri dataset e proxy: solo un massimo – sui 6 mostrati- (14.5-15 anni) è nettamente entro una fascia rosa, mentre altri due (5-6 e 21-22 anni) sono al bordo inferiore delle rispettive fasce. In particolare il periodo 21-22 anni era uscito dalla fascia lo scorso aprile e da allora si è avviato lentamente a rientrare (a novembre ’12 è rientrato completamente), indipendentemente dal passaggio alla vers.3.2.

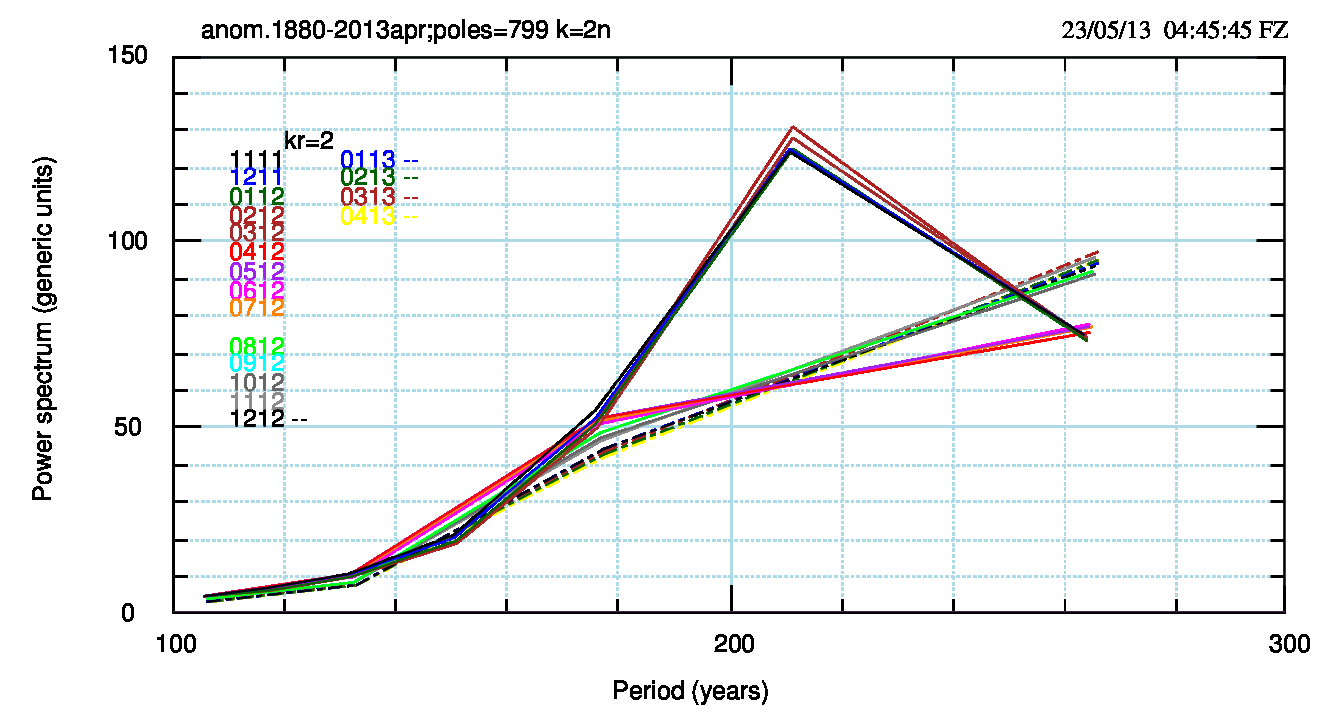

Nella Fig.8 (pdf) l’andamento temporale del periodo di maggiore potenza (circa 211 anni e “non astronomico”). Ribadisco che:

- avendo un dataset di 132 anni e 4 mesi i massimi di 130 anni o superiori sono poco indicativi, e che

- l’ultimo punto sul grafico, per ogni mese, si configura come un massimo a circa 265-266 anni

che, pur essendo poco significativo, mostra un andamento temporale non casuale, come si può vedere nel grafico sul sito di supporto (pdf, png).

L’improvvisa scomparsa del massimo di 211 anni avviene ad aprile 2012 e la nuova versione 3.2 non modifica la situazione anche se in corrispondenza di questo periodo si nota un aumento della potenza. Da notare anche l’evidente scostamento dello spettro “vers.3.2” rispetto ai mesi precedenti, quando il picco di 211 anni era già scomparso. Per il mese di gennaio 2013 si nota che lo spettro è indistinguibile da quello del dicembre precedente, tanto da sembrare non presente nel grafico.

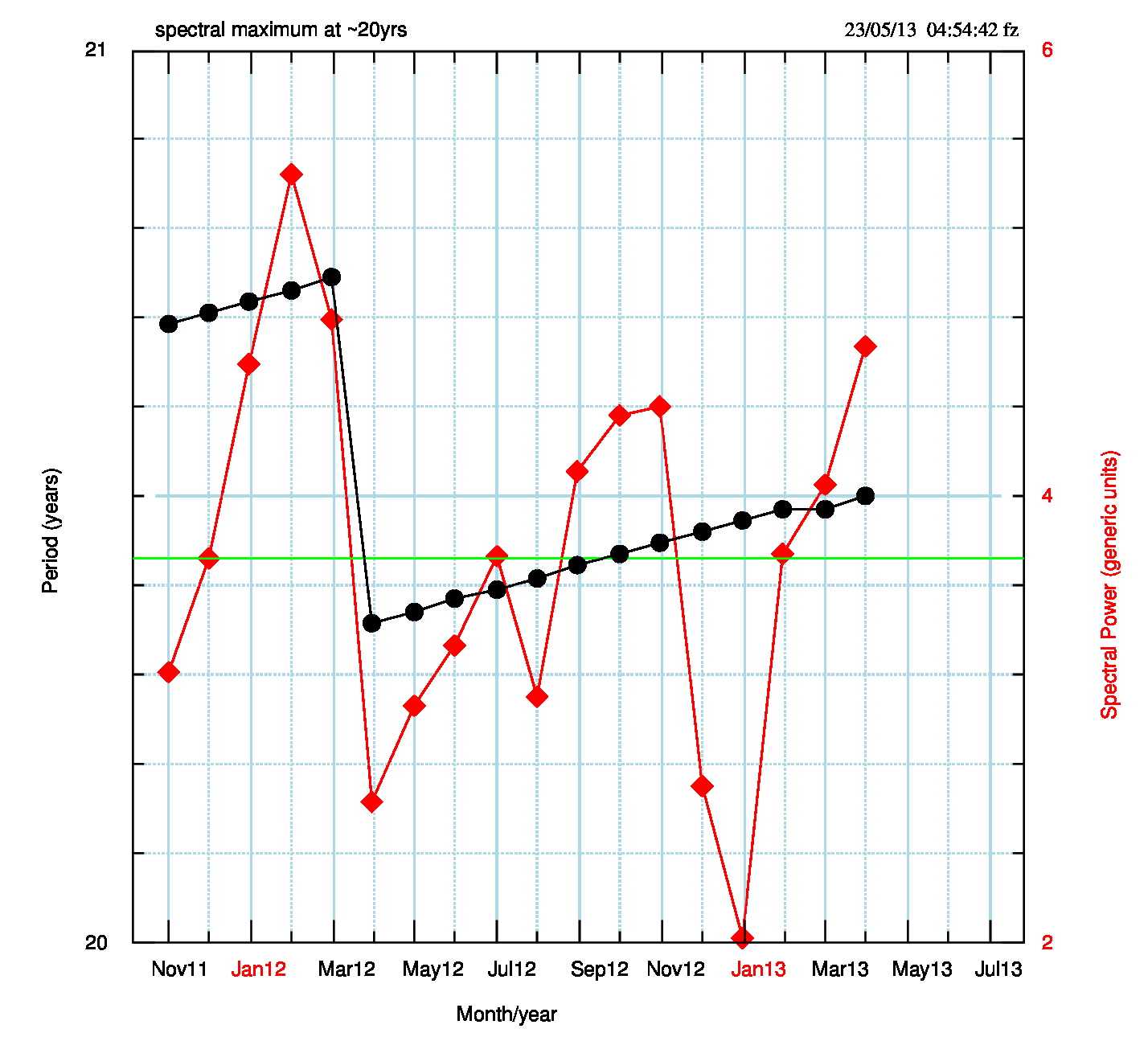

Per quanto riguarda altri massimi presenti nello spettro,la Fig.9 (pdf), relativa al picco di 20-21 anni, mette in evidenza un salto improvviso, sia nella durata del periodo che nella potenza spettrale, ad aprile 2012; dopo questa data, però, si nota un’evoluzione quasi continua che risente poco del passaggio alla nuova versione del dataset e in qualche modo giustifica il fatto che venga qui mantenuta la “storia” della vers.3.1. Però questo significa anche che la nuova versione non modifica sostanzialmente lo spettro e che quindi non è in grado di ripristinare i picchi di 62 e 211 anni, scomparsi durante la vita del dataset “sbagliato” 3.1 e da considerare ormai definitivamente “defunti”. Per questo motivo sono stati eliminati dai dati, rimandando ai post precedenti per una loro visualizzazione.

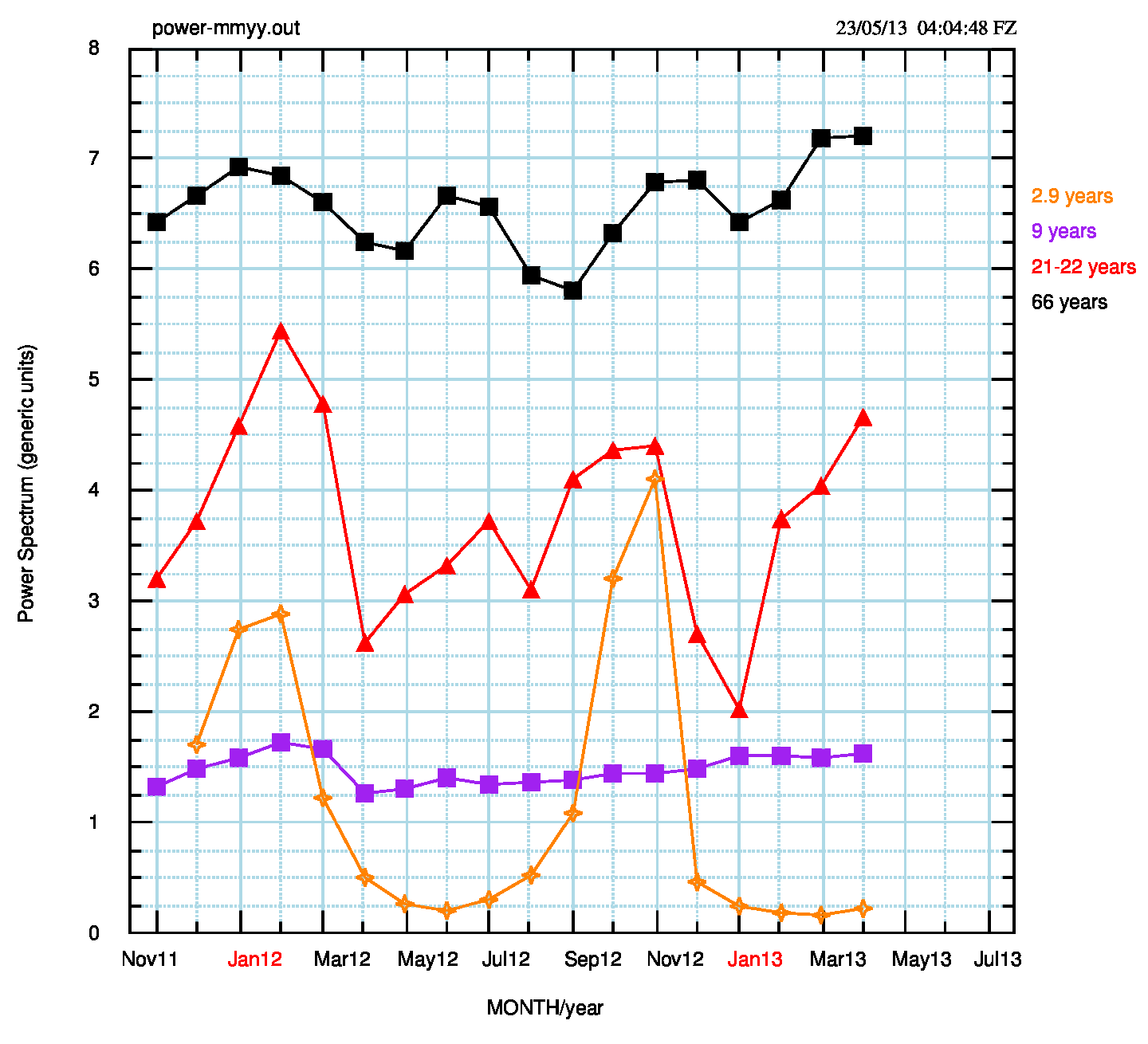

La potenza dei periodi di 66, 21-22, 9 e 2.87 anni è riportata nella tabella e rappresentata in Fig.10 (pdf).

Il massimo di 21-22 anni mostra una forte risalita (il 131% in tre mesi) rispetto al minimo assoluto di gennaio. La stessa cosa, molto meno evidente (aumento del 12.3%), si nota per il massimo di 66 anni. Commenti sul picco di circa 2.87 anni si trovano su CM (qui e qui). Questo picco ha un andamento (pdf png) di potenza/periodo simile al picco di 21-22 anni

Dal grafico si vede che tre dei quattro periodi si comportano nello stesso modo, con un andamento oscillante di periodo 10-11 mesi (0.83-0.92 anni, evidenziato nello spettro con un debole massimo a 0.834 anni). I periodi di 66 e 21-22 anni mostrano anche un massimo secondario centrato a giugno-luglio 2012. La potenza del periodo di 9 anni resta costante, con una tendenza a crescere debolmente da luglio ’12 in poi, con un accenno di massimo secondario a giugno ’12 e gennaio ’13. Nei successivi tre mesi la potenza resta quasi costante.

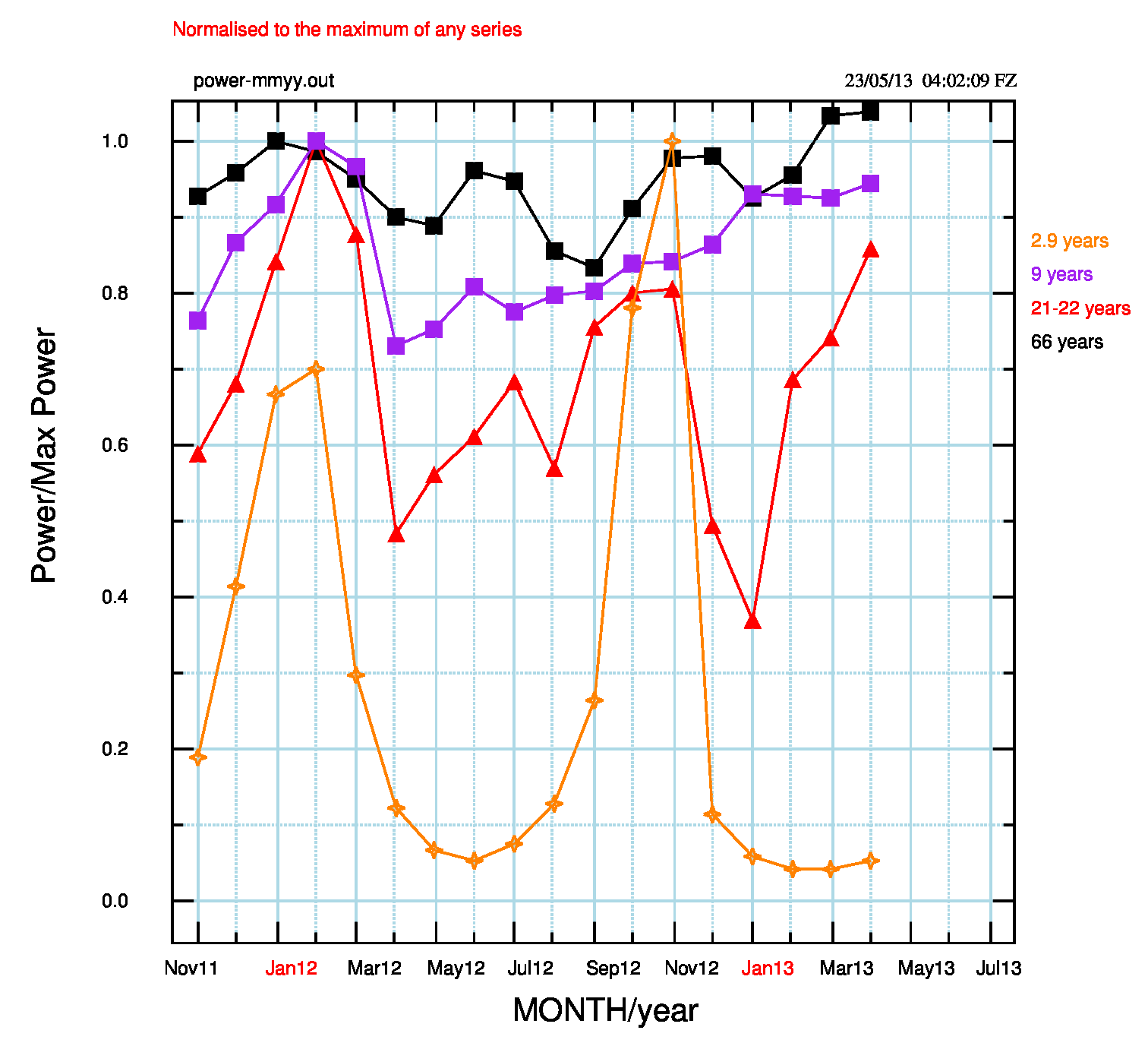

Se si normalizzano le potenze dei quattro picchi, si possono mettere in evidenza alcune differenze e similitudini. Normalizzando rispetto al valore massimo di ogni serie (Fig.11) si ha (pdf).

Una potenza che grossolanamente si comporta allo stesso modo per tutti i picchi, con alcune differenze significative:

- Tutti i periodi mostrano un massimo a gennaio-febbraio

- Il secondo massimo (a novembre-dicembre) non è presente per il periodo di 9 anni che, dopo agosto 2012, si mostra in opposizione di fase rispetto agli altri periodi. Anche nei tre mesi oggetto di questo post, pur in una sostanziale costanza, sembra di vedere un’opposizione di fase rispetto a 66 e 21 -22 anni.

- il periodo di 2.9 anni è l’unico a non mostrare un massimo secondario a giugno-luglio (5 mesi dopo il primo massimo) e anzi presenta un profondo minimo a giugno, solo leggermente inferiore al minimo di marzo

- il periodo 2.9 anni mostra la maggiore escursione nella potenza.

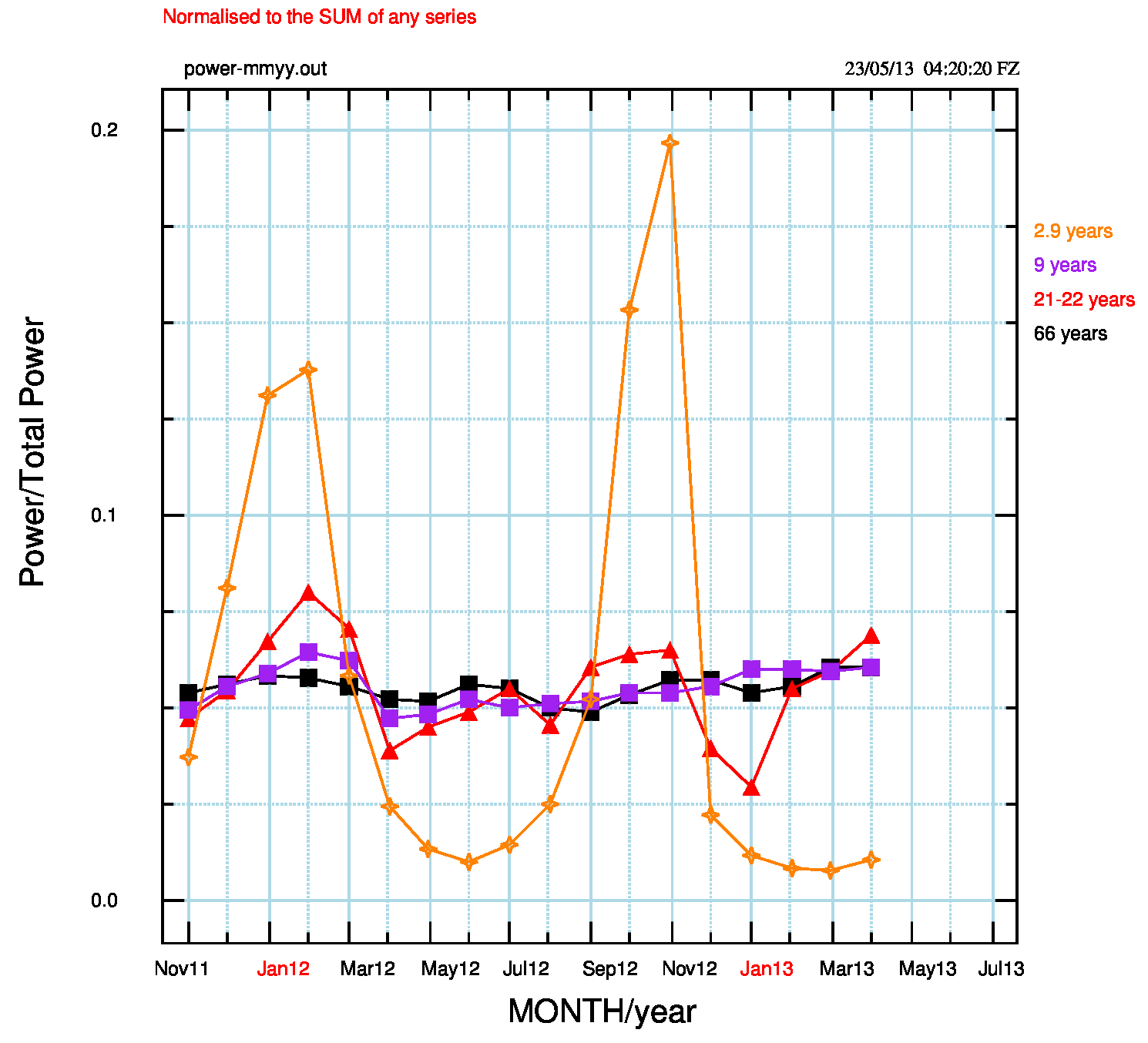

La Fig.12 (pdf) in cui sono mostrati i dati di Fig.10, normalizzati rispetto alla somma delle potenze, sottolinea la grande escursione del periodo di 2.9 anni, la similitudine tra gli altri tre periodi e l’oscillazione, più ampia ma tutto sommato contenuta, del periodo 21-22 anni.

Sarà probabilmente necessario attendere l’eventuale nascita ed evoluzione di un nuovo periodo di oscillazione, ma il periodo di 2.9 anni sembra avere alcune differenze rispetto agli altri. Oltre alla grande estensione massimo-minimo, il minimo ben strutturato e senza fluttuazioni fa pensare che dipenda da influenze diverse. Ad esempio il massimo secondario a giugno-luglio presente negli altri tre periodi potrebbe nascere dal fatto che il dataset globale risente di differenze nord-sud, differenze che non sembrano interessare il periodo di 2.9 anni. Le similitudini nell’evoluzione temporale delle potenze spettrali fanno pensare anche a qualche influenza del processo di omogenizzazione che può (parzialmente) nascondere l’eventuale evoluzione climatica.

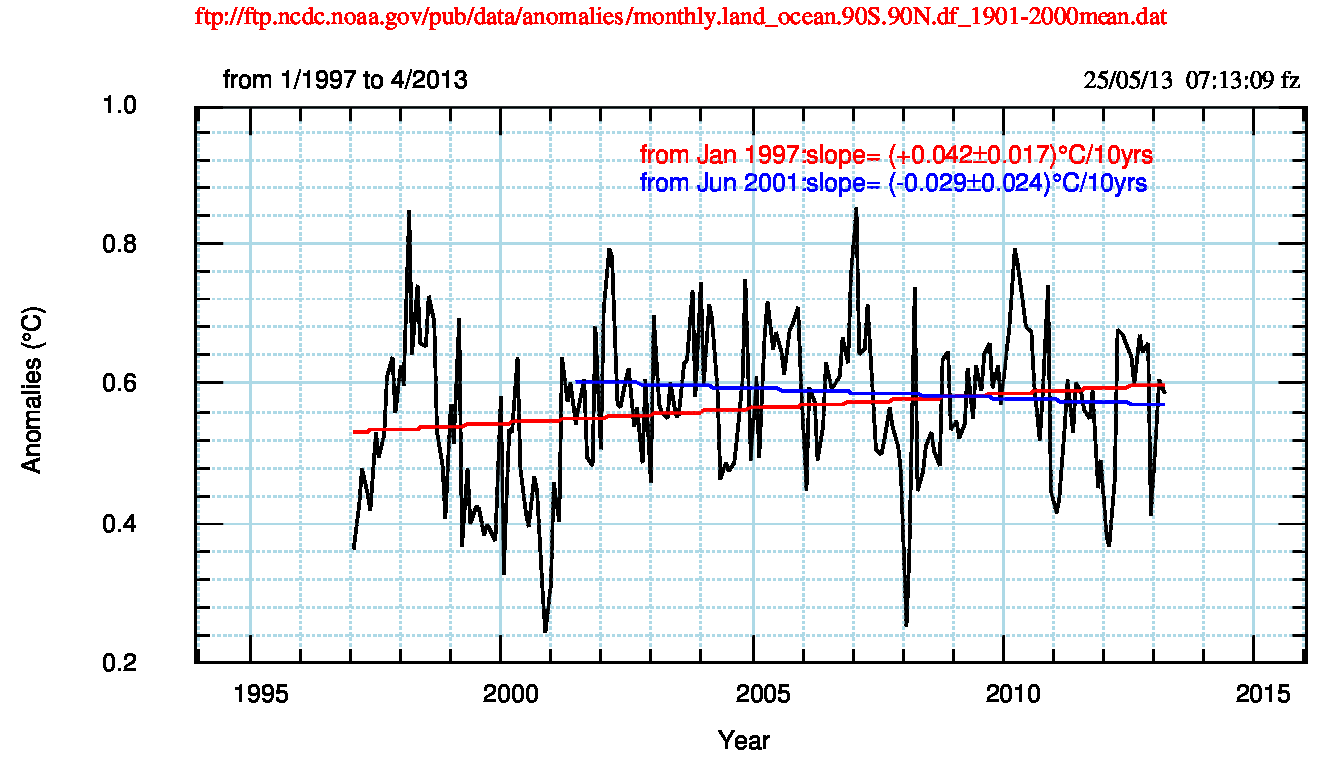

Per finire, e anche per confrontarsi con l’immagine in questi giorni presente sulla colonna di destra di CM, nonchè con qualche polemica apparsa recentemente (con seguito su CM qui), mostro nella Fig.13 (pdf) le anomalie di temperatura tra gennaio 1997 e aprile 2013 con il fit lineare anche da giugno 2001, come mio modesto contributo al giochino del “si scalda, non si scalda” basato su coefficienti di correlazione di circa ±0.1 e su valori di χ2 del tutto ridicoli per più di 100 gradi di libertà (valori numerici qui e qui): quindi il giochino diventa “non si scalda”.

[…] Si può trovare una descrizione dell’aggiornamento precedente (febbraio-marzo-aprile 2013) qui. L’aggiornamento di maggio 2013 non è stato descritto ma non mostra situazioni particolari e […]

@Giovanni

Sono parzialmente d’accordo con te per due ordini di motivi

1)Le correzioni sono minime e tendono a stabilizzarsi attorno al centesimo

di grado, tranne un periodo attorno al 1990 dove sono circa tre volte più

ampie e con fluttazioni da mese a mese abbastanza più ampie. Per questo ho

deciso, dai dati di gennaio 2013, di non fare più post mensili ma

almeno trimestrali.

2)Osservazioni contro riduzioni: non sono in grado di fare esempi in

geologia e quindi ne farò uno in astronomia, mia materia. Malgrado la

maggior parte degli astronomi e dei fisici creda che l’astrononomia sia una

branca della fisica, a mio parere non è vero. Come si può

leggere su Unsold – Il nuovo cosmo – Piccin Editore, Padova, 1969, pag 90:

“Astronomia+Fisica = Astrofisica”, cioè l’astronomia non è solo

(Astro)Fisica, ma la somma di due termini, dei quali il primo, cioè

l’astronomia, deve essere considerato una scienza naturale, come la botanica

o la geologia ed ha bisogno, all’inizio, di un periodo di classificazione

“botanica” dei fenomeni, di una “stratigrafia” delle situazioni possibili.

Quindi, sottolineare l’importanza del lavoro empirico, “sul campo”, com me

significa sfondare una porta aperta.

Però, all’inizio. Il lavoro “sul campo” deve per forza essere la

premessa per costruire un modo (per me matematico, ma potrebbe anche essere

filosofico, artistico, musicale …) di definire i problemi e di

provare a risolverli. E sono sicuro che anche i geologi si comportano nello

stesso modo.

Manipolazione (ovviamente nel senso di elaborazione e non di trucco) e

giochini grafici. Cominciamo con i grafici: il programma grafico che uso l’ho

scritto io, in molti anni, a partire dal comando assembler che accende un pixel

sullo schermo e aggiungendo via via le routine di elaborazione e il

linguaggio di comandi. Ogni volta che mi sono servite, ho usato le routine di

Numerical Recipes. Ti prego di credere che quando disegno un grafico so

esattamente cosa faccio. Poi, sono in pensione da un po’ più di due

anni e non devo vendere niente a nessuno e nemmeno ho bisogno di

“turlupinare” i lettori di CM che leggono benissimo i grafici per proprio

conto.

Le elaborazioni che faccio sono essenzialmente due: fit lineari (a volte

parabolici; molto di rado uso polinomi del terzo o quarto ordine),

cioè giochini per bambini dell’asilo, e spettri di potenza di serie

temporali climatiche. Le rappresentazioni grafiche servono a mettere in

evidenza alcuni aspetti che noto nei dati numerici e che propongo ai lettori di

CM e molto

spesso il primo ad avere dei dubbi sono proprio io. Per questo nel sito di

supporto deposito tutti i miei dati numerici: chiunque può

controllare e graficare a modo suo i miei risultati. E’ possibile anche

scaricare dal mio sito il programma di graficazione (eseguibile e listato: dentro

ha i comandi per l’analisi spettrale).

Noto una certa disistima nei confronti dei geografi: negli ultimi tredici

anni ho insegnato (quest’anno è stato l’ultimo) didattica della

geografia e nel giudizio sui geografi sono d’accordo con te … e come te

sbaglio profondamente. Anche i geografi, come tutti gli altri, sono di tante

“razze” che si occupano dei più svariati argomenti, dai parolai

inconcludenti agli scienziati seri e rispettabilissimi.

Per il resto, concordo con quanto scrive Donato, che ringrazio per il

commento.

@Donato

Hai ragione per la didascalia. Grazie. Quella corretta è questa:

Fig.7: Come Fig.6. In evidenza la situazione per i

massimi di periodo minore. I massimi di periodo 21-22 e 66 anni,

mostrano un sensibile aumento di potenza rispetto a gennaio 2013.

Per l’influenza del processo di omogenizzazione, anche io credo che sia

poco importante, ma non posso fare a meno di notare (Fig.10) la fase comune

ai massimi e ai minimi e quindi sottolineo la possibile esistenza di interazioni

numeriche.

Franco

” tranne un periodo attorno al 1990 dove sono circa tre volte più

ampie”.

Il periodo è attorno al 1890, come si vede dai grafici di Fig.2 e 3. Chiedo scusa per l’errore di battitura.

Franco

“Le similitudini nell’evoluzione temporale delle potenze spettrali fanno pensare anche a qualche influenza del processo di omogenizzazione che può (parzialmente) nascondere l’eventuale evoluzione climatica.”

.

Se non ho capito male i cicli dei massimi e minimi delle potenze spettrali potrebbero essere un artefatto dell’algoritmo di omogeneizzazione. Se così fosse i periodi dei minimi e dei massimi non sarebbero significativi da un punto di vista fisico per cui tutte le nostre considerazioni sulle cause dei vari periodi sarebbero prive di senso. Franco, credo, però, che il fatto che alcuni periodi siano in controfase e che alcuni periodi siano ben strutturati (periodo di 2,9 anni) mentre altri siano un poco confusi depone a sfavore di questa interpretazione.

Comunque, se fosse vera la dipendenza dei cicli dal processo di omogeneizzazione avremmo individuato un altro bug nell’algoritmo, se questa dipendenza non esistesse potremmo ancora azzardare delle ipotesi interpretative dei periodi dei massimi e minimi delle potenze spettrali.

p.s.

comunicazioni di servizio 🙂

@ F. Zavatti: la nota della fig. 7 presenta qualche errore di battitura in quanto il senso è piuttosto oscuro;

@ adm.: i link a monte della fig. 13 (qui e qui) non funzionano (almeno a me).

Ciao, Donato.

Link sistemati.

gg

A me questi grafici rielaborati, sulle anomalie mensili anno x anno sembrano un poro esercizio stilistico che nulla dovrebbero aggiungere o togliere alla realtà. Sappiamo nbenissimo che con questi giochini i grafici si possono manipolare e modificare radicalmente. Ho visto questo modus operandi nel 2007 a dei corsi tenuti all’UNiversità di Ginevra da sedicenti esperti climatici dell’epoca facenti parte dell’IPCC. IO da bravo geologo abituato a vedere un grafico come cosa oggettiva rimasi esterrefatto. Con le loro manipolazioni matematiche riuscivano a dimostrare che il clima era impazzito, che tutto si stava scaldando … parola di economisti, e geografi!

Da qui nasce tutto l’equivoco e tutta l’inutile e strile discussione che siamo obbligati ad avere con “la scienza dell’AGW”. Manipolatori matematici e informatici che hanno rubato il posto a chi voleva studiare il pianeta, questo è il dato di partenza. Dal mio punto di vista personale basato sulle mie esperienze, la degenerazione del mondo accademico, la sua trasformazione in “azienda” che deve produrre ( articoli, pubblicazioni, carta piu o meno igienica) sono intimamente legati con le assurdità che vediamo e sentiamo ora a propostio di clima e non solo. E per finire non dimentichiamoci che i cambiamenti di cui sitamo parlando e che sono stati messi in tutte le salse sotto forma di grafici di ogni tipo non rappresentano che delle microscopiche variazioni rispetto alle reali variazioni climatiche della Terra registrate nelle rocce e nei sedimenti. La PEG e l’optimum medioevale non sono altro che delle gocce d’acqua rispetto all’oceano delle variazioni avute durante i periodi glaciali e interglaciali quaternari ( senza andare a disturbare il prequaternario).

Giovanni, tu non hai torto e le tue considerazioni sono quasi del tutto condivisibili. Il problema, però, è che oggi come oggi la scienza del clima è del tutto basata su archivi di dati su cui si interviene mediante elaborazioni statistiche e, ancora purtroppo, gli output di tali elaborazioni rappresentano lo stato dell’arte della climatologia e la base dei documenti per i decisori politici e non. Ci piaccia o meno, purtroppo, questa è la lingua della climatologia: set di dati, regressioni lineari e non lineari, intervalli di confidenza e barre di errore, correlazioni, analisi econometriche, ecc., ecc.. Troppa matematica e poco empirismo? Forse si, ma se si vuol intavolare un discorso è necessario individuare una lingua comune e questa lingua è rappresentata dalla matematica della probabilità, dalla statistica. Tanto per dirne una, in questi giorni mi sto scervellando sull’ultimo “parto” del dr. Briffa: una ri-analisi dei dati proxy degli alberi di Yamal basata su matematica, probabilità, statistica, codici di calcolo più o meno pacificamente accettati e via cantando. Non per niente S. Mc Intyre e la sua allegra combriccola di statistici amatoriali e professionali hanno iniziato a fare le pulci al paper e ne vedremo (e leggeremo) delle belle.

So che tu non sei assolutamente d’accordo con questo tipo di impostazione del problema: appena qualche giorno fa te la sei presa con matematici, informatici, fisici, statistici e … ahimé, ingegneri 🙂 rei di snaturare una scienza che dovrebbe essere basata sullo studio del passato e, quindi, dei record stratigrafici e, invece, è diventata una disciplina basata sull’interpretazione matematico-ingegneristica dei dati. Io ho esordito scrivendo che le tue argomentazioni sono “quasi” del tutto condivisibili. Ora cercherò di spiegare che cosa intendo con quel “quasi”.

.

Partiamo dalle analisi numeriche che il prof. F. Zavatti sta conducendo sui record di dati della temperatura superficiale del NOAA. Come credo tu abbia già visto, si tratta di dati che, mensilmente, vengono aggiornati. L’aggiornamento, come ha scritto F. Zavatti, avviene mediante un algoritmo che modifica TUTTA la serie di dati (problema n° 1); tende ad eliminare o ridurre tutte le periodicità presenti nei dati grezzi e a linearizzare il dataset (problema n° 2); è una versione aggiornata di un altro algoritmo che introduceva errori sistematici rilevanti nelle serie di dati e, a lungo andare, li avrebbe completamente snaturati (problema n° 3). I grafici e le considerazioni di F. Zavatti, pertanto, devono essere letti in questa ottica: revisione e controllo di elaborazioni numeriche basate su algoritmi che, in passato, si sono rivelati errati. Questi articoli che io apprezzo molto (essendo ingegnere non potrei fare diversamente 🙂 ) ci consentono di essere al passo con i tempi. Ci consentono, cioè, di parlare la stessa lingua dell’odierna climatologia. Che poi essa possa essere cacofonica è un altro paio di maniche.

.

Per quanto riguarda i dati, anche quelli geo-litologici, credo che un minimo di elaborazione debba essere accettata in quanto è difficile (se non impossibile) mettere in relazione una carota di sedimenti con le temperature superficiali. Il problema sorge, invece, quando questi dati vengono manipolati o sono assoggettati ad elaborazioni statistiche i cui risultati vengono interpretati in modo del tutto fuorviante. In un precedente commento, non ricordo se tuo o di giovanni geologo, è stato citato il caso delle differenze tra la tesi di dottorato di Marcott ed il paper di Marcott et al. 2013. Per quel che ho potuto valutare io, l’errore più grosso (a parte la differenza tra tesi e paper che potrebbe anche starci) è stato il modo in cui è avvenuta la comunicazione del messaggio scientifico: mai negli ultimi 11.500 anni le temperature sono state più elevate di oggi. Si tratta di una sovrastruttura mediatico-propagandistica di cui sono responsabili anche gli autori dello studio, che non trova riscontro nella pubblicazione stessa.

Per concludere io concordo con te sul fatto che le spiegazioni delle attuali oscillazioni climatiche vanno ricercate nel passato del nostro pianeta e quindi nei record geologici, ma senza un po’ di matematica quei dati sarebbero del tutto illegibili o privi di senso. Che poi qualcuno esageri e affoghi la realtà dei dati nel mare delle funzioni di regressione è anche vero.

Ciao, Donato.