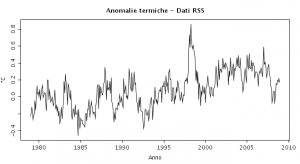

Qualche giorno fa abbiamo pubblicato i dati provenienti dalle sonde satellitari per il mese di dicembre riscontrando un’anomalia positiva leggermente inferiore a quella dei mesi di ottobre e novembre. Dati che hanno riportato il 2008 verso un andamento medio, dopo un buon numero di mesi con anomalia negativa. E così l’anno si è chiuso all’insegna della noia, cioè in media. Secondo i calcoli dovrebbe essere al quindicesimo posto negli ultimi trent’anni, cioè da quando esiste questa tecnica di misurazione. Per informazione, sempre secondo le sonde satellitari sarebbe stato anche il più freddo degli ultimi otto. Dal punto di vista del clima questo non vuol dire molto, ma conferma il trend di diminuzione innescatosi negli ultimi anni.

A terra sembra che il discorso sia diverso. Il database dell’Hadley Centre classifica il 2008 come decimo più caldo dal 1850, confermando il trend di riscaldamento dall’inizio dell’era moderna. Metodi diversi, database diversi, periodi diversi, temperature diverse. C’è da farsi venire il mal di testa. Cerchiamo di capirci qualcosa in più. Le sonde satellitari hanno il grave difetto di essere una tecnologia giovane. Trent’anni sono pochi, ma con un pò di pazienza arriveranno ad essere considerate l’unica fonte oggettivamente utilizzabile per compiere queste misurazioni. Le stazioni terrestri, su cui si fonda la raccolta dati dell’Hadley Centre, della NASA e della NOAA , non costituiscono una fonte di informazioni affidabile. Tutte le serie di questi centri di raccolta, sono soggette a pesanti condizionamenti indotti dall’effetto isola di calore (UHI ), dalla drastica riduzione dei punti di osservazione, dall’assenza di standardizzazione della strumentazione e da molto altro ancora.

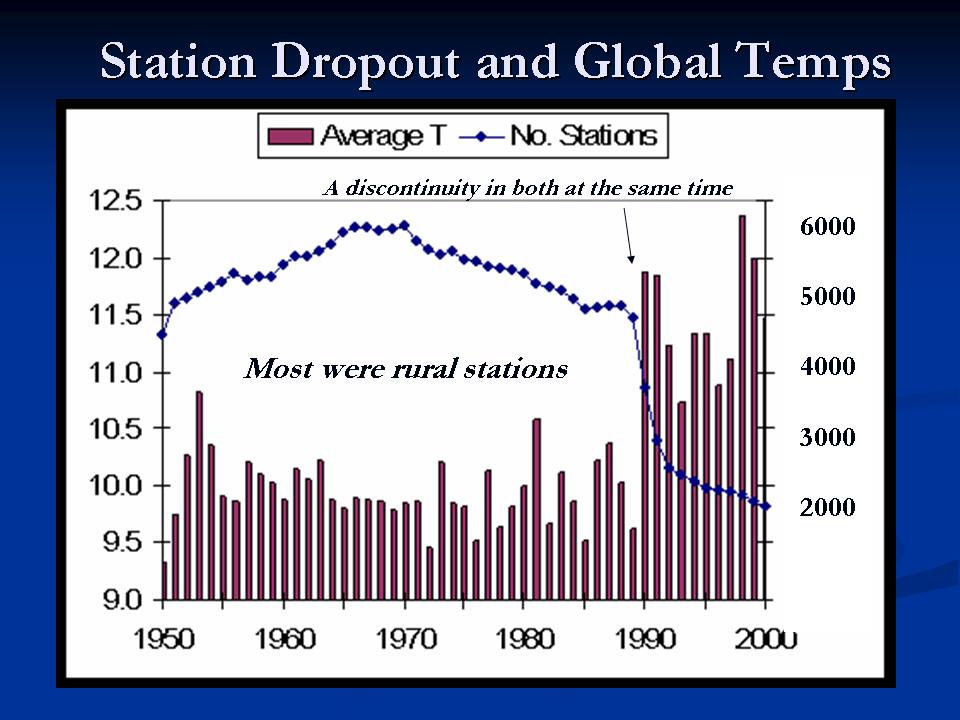

Per ovviare in qualche modo a questi inconvenienti si applicano degli algoritmi di correzione spesso differenti da un database all’altro che, oltre a produrre informazioni discordanti, sembrano essere disegnati appositamente per favorire un risultato che esalti la tendenza all’aumento delle temperature.  Se a questo si aggiunge che le misurazioni sul mare, fatta eccezione per uno sparuto numero di boe e di piattaforme, avvengono ad opera delle navi mercantili e militari il quadro è completo. Tra tutte queste problematiche, quella forse più significativa è la riduzione del numero delle stazioni di osservazione, perchè ha interessato soprattutto stazioni rurali, cioè quelle che forniscono i dati più rappresentativi. In alcune parti del mondo quali l’est europeo e la Siberia, questo fenomeno è stato più evidente negli ultimi venti anni e non è difficile capire perchè. Le enormi problematiche sociali che queste aree hanno affrontato dopo la caduta del muro di Berlino hanno decisamente fatto scendere l’osservazione meteorologica nell’ordine delle priorità , laddove in precedenza il controllo fisico e militare del territorio imponeva una politica molto diversa. A questo link  si trova una interessante animazione prodotta da un team dell’università del Delaware, che spiega molto bene quanto è accaduto.

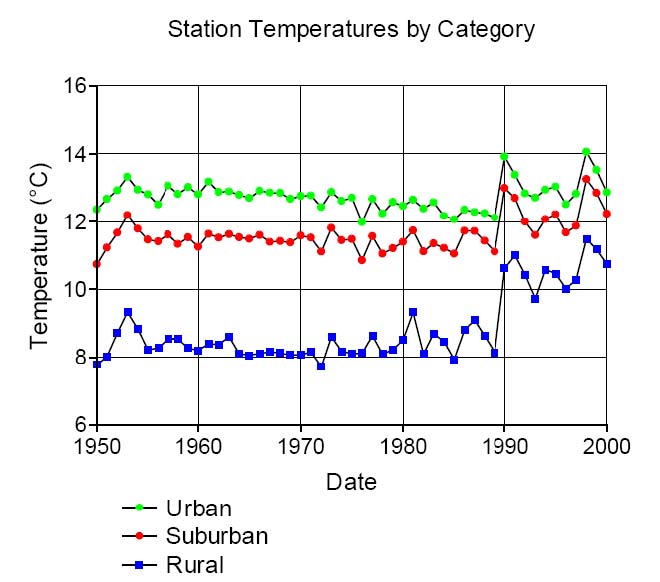

Per costruire un database di osservazioni omogeneo e rappresentativo su base areale e non puntuale, è necessario cotruire una griglia sul territorio, popolando ogni quadratino con i dati provenienti dalle stazioni in esso contenute. Per tutti i quadratini privi di osservazioni si devono utilizzare quelle dei quadratini confinanti, cercando anche di tener conto della distanza. Aumentando il numero dei vuoti il livello di approssimazione non può che aumentare, infatti un quadrato precedentemente popolato con dati provenienti da stazioni rurali, può capitare che sia riempito con i dati provenienti da stazioni urbane circostanti. Questo avviene probabilmente in modo massiccio per i dati della Siberia che, guarda caso, è la zona del mondo che si è “scaldata” di più negli ultimi anni. Confrontando l’andamento delle temperature con il grafico del numero delle stazioni, scopriamo infatti che le prime hanno velocemente cominciato a salire quando le seconde sono scese drasticamente.

Nella storia dell’umanità le nuove tecnologie, dopo aver dimostrato la loro affidabilità , hanno sempre sostituito le tecniche precedenti. Quanto tempo ci vorrà perchè la smettano di propinarci dati addomesticati provenienti da un sistema di raccolta inadeguato? Temo parecchio, perchè le temperature misurate via satellite non ne vogliono sapere di aumentare quanto dovrebbero.

![Reblog this post [with Zemanta]](http://img.zemanta.com/reblog_e.png?x-id=19e5509c-ed31-4366-9787-f60bff984da7)

Ma io mi chiedo da sempre,le t°satellitari son attendibili? cioè come fanno a rilevare la t°dell’aria a 1,80 mt da terra,come da norma e senza schermi o capannine? e dov’e’ nuvoloso,mi dite come fanno a rilevare la t° a 1,80mt da terra e sotto la coltre di nubi?

Si sono attendibili ancor di + delle rilevazioni a terra per un discorso legato alla rilevazione di massa di aree calde e fredde. Dal satellite è possibile rilevare con precisione assoluta le temperature al suolo. Ti posso spiegare in pvt, Scrivimiciao

mario tozzi ,cecchi paone,maracchi…il trio serra….mi domando cosa ne possa sapere un geologo e un divulgatore scientifico ,ma cio che mi preoccupa é maracchi un pezzo da 90 del CNR….mi chiedo che gente lavora in questo paese….

Comunque il ‘radiometro’ dovrebbe funzionare sulla ‘Legge di Stefan-Boltzmann’ ovvero rilevare la potenza irradiata dalla Terra per calcolare la ‘temperatura di emissione’ T, E=sigma*T^4…

Unico problema, non da poco, è il fatto che c’è l’Atmosfera di mezzo che assorbe e che può quindi falsare la misura: infatti se questa assorbe radiazione il satellite o sonda rileva una ‘potenza di emissione’ minore e quindi andrebbe a ‘sottostimare’ le temperature al suolo, a meno che non si tenga conto del raggiungimento dell’equilibrio radiativo su tutta la colonna d’aria atmosferica…

Aspettiamo il post di Gravina per vedere se riesce a sciogliere l’enigma…

@ Lorenzo

Claudio Gravina sta scrivendo proprio su questo, presto troverai un post dedicato ai metodi di telerilevamento.

Quanto alla mano fai bene a tenerla a posto, perchè lì fa talmente caldo che rischieresti di bruciarla. A parte gli scherzi, certamente l’aumento non è interamente dovuto all’effetto UHI, piuttosto c’è sicuramente un pesante bias con segno positivo. Non mi risulta però, e trovi conferma di questo nei link della mia risposta al commento di Maurizio, che nessuno si sia dato pena più di tanto per risolvere il problema, visto che “A qualcuno piace caldo” :-).

gg

Vediamo un pò: discutiasmo i metodi di rilevazione delle temperature:

qual’è il principio fisico esatto su cui si fonda la rilevazione delle temperature al suolo da satellite: il semplice ‘radiometro’ o altro?

Inoltre io non ci metterei la mano sul fuoco che l’aumento di temperatura in Siberia sia dovuto all’isola di calore delle stazioni urbane…

Salve Maurizio,

la fonte principale è il DB del GHCN, che trovi a questo link: http://www.ncdc.noaa.gov/oa/climate/ghcn-monthly/index.php.

Qui c’è una prima rielaborazione: http://www.uoguelph.ca/~rmckitri/research/intellicast.essay.pdf, si tratta del sito dove scrive Joe D’Aleo.

Su questa pagina invece c’è un altro lavoro (da cui il grafico): http://www.uoguelph.ca/~rmckitri/research/nvst.html; la pagina è a cura di Ross McKitrick. Ci sono anche i dati raw in formato xls, la spiegazione del procedimento di calcolo ed il link al data coverage del GISS che, pur in una forma grafica diversa mostra per le stazioni dati molto simili.

gg

Speriamo che anche Mario Tozzi legga questo post. Proprio qualche giorno fa ribadiva in TV che il 2008 è stato all’ottavo posto degli anni più caldi dal 1850, ovviamente indicando, secondo lui, con estrema sicurezza l’attività antropica come causa.

Qual’e’ la fonte del grafico “Station Dropout and Global Temps”? Sembrerebbe quasi un rigore da tirare senza portiere