Nella passeggiata di ieri sera su Twitter, mi sono imbattuto in un interessante articolo su Wetter Undeground, in cui si parla della collaborazione tra IBM e NCAR per la realizzazione di un nuovo modello atmosferico. Per la verità all’inizio sembrava si trattasse di qualcosa di già operativo, leggendo si capisce poi che la faccenda è ancora lunga, ma presenta comunque diversi spunti interessanti e anche qualche perplessità.

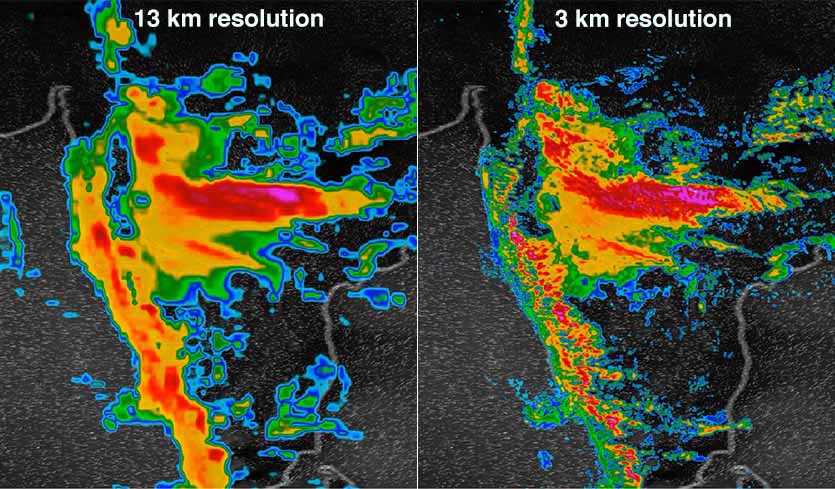

L’elemento di novità consiste nel fatto che questo modello avrà una griglia variabile, ossia una definizione che andrà da 3 a 10km, in sostanza scendendo fino alla definizione di un local model, soprattutto sulla terraferma. Il tema della definizione spaziale (sia orizzontale che verticale) di un modello atmosferico, è un tema di capacità di calcolo, perché far funzionare un modello significa di fatto riprodurre per ogni box della griglia il comportamento del sistema e questo comporta calcoli al limite del sostenibile con le tecnologie attuali. Ma è anche – forse soprattutto – un tema di conoscenza e riproduzione delle dinamiche atmosferiche alle dimensioni della definizione del modello, sotto la quale, nulla può essere “risolto” ma deve essere necessariamente sviluppato in base a processi standard, definiti parametrizzazione. Per esempio, la bolla d’aria che dà origine ad un cumulo, che poi diviene una nube ad elevato sviluppo verticale e poi diviene un temporale e forse anche una supercella, è qualcosa di poche decine di metri di diametro, così come il singolo temporale ha o può avere in effetti poi una dimensione di pochi chilometri. Quindi una cella di 10Km di diametro potrà avere al suo interno molti temporali, tutti dal comportamento – diciamo così – standard, mentre una cella di 3km può risolvere il singolo temporale in funzione delle dinamiche che lo hanno generato e lo sostengono.

Scendere alla scala spaziale dei local model, sebbene solo su di una parte della griglia, con un modello globale, sarebbe in effetti un grosso passo avanti, fermo restando che tutta la fisica e la costruzione del modello stesso deve ancora essere soggetta a verifica.

Altro elemento di novità, l’utilizzo delle GPU, Graphic Processing Units, quelle dei videogiochi per capire, al posto delle classiche CPU, con le prime che sono molto più performanti nel calcolo. Qui i ragazzi dell’IBM e dell’NCAR hanno peccato un po’ di presunzione, perché nella modellistica atmosferica le GPU sono senz’altro una novità, ma loro non sono gli unici a conoscerla, visto che si utilizzano anche da noi per scopi molto simili.

Infine, pare che il nuovo modello avrà una frequenza di aggiornamento mai vista prima, addirittura una corsa ogni ora, contando sull’assimilazione di un numero altissimo di informazioni, quelle provenienti addirittura da smartphone e/o da stazioni amatoriali. Per far questo, scrivono, sarà necessario un serio algoritmo di controllo qualità.

Ora, tutte queste novità, suscitano però anche qualche dubbio.

Innanzi tutto, non sono riuscito a trovare documentazione necessaria – se qualcuno lo facesse glie ne sarei grato – ma sembra che il modello sia idrostatico, come tutti i global model, che però non scendono appunto sotto i 9Km di definizione orizzontale (ECMWF). Scendere a 3km per risolvere la convezione con un modello idrostatico è un esperimento alquanto bizzarro, visto che tutti i local model sono appunto non-idrostatici, proprio per poter risolvere i moti verticali di piccola scala che sono all’origine della convezione stessa. Ma vedremo…

Sulla frequenza di aggiornamento, verrebbe da dire cui prodest, visto che immagini ben definite dello stato iniziale dell’atmosfera, in cui quindi oltre alle osservazioni orarie, ai satelliti ed agli aeroplani, entrano anche le osservazioni sinottiche e, soprattutto, i radiosondaggi, sono disponibili solo ogni sei ore, anzi, quelle delle 12 e delle 24 sono certe, le altre molto meno… Con un’analisi “incerta” è difficile che possa essere “più certa” la previsione, ma anche questo si vedrà con la verifica.

Tutto ciò detto, entro la fine del 2019 partiranno le prime corse operative, inizialmente fino a T+12, mentre una versione beta del modello con più bassa risoluzione già pare giri a T+120. Prima di arrivare ai dieci giorni e oltre ce ne corre, ma si comincia sempre dall’inizio ;-).

Che dire? Buone previsioni!

Caro Guido,

se non chiedo troppo, sarei molto interessato a conoscere qualche ulteriore dettaglio sulla trasmissione e soprattutto utilizzazione di dati meteo (posizione e quota, temperatura, umidità, vettore del vento) misurati su aerei in volo.

I fornitori di previsioni per il volo a vela (Meteowind, ecc.) mi ripetono che i loro modelli non possono aggiornarsi con “dati sparsi” (ottenuti opportunisticamente invece che a ore e posizioni programmate, come i sondaggi verticali classici).

La questione per noi volovelisti è attuale, perché da un paio di anni, grazie alla grande diffusione del nostro sistema anticollisione FLARM, abbiamo sviluppato una rete dati capillare da aria a terra (vedi live.glidernet.org) in rapida espansione, che per ogni aliante (e ormai molti altri aeromobili), oltre alla loro posizione, potrebbe anche inviare al nostro server centrale dati meteo accurati in tempo reale e a costo praticamente nullo, ma i modelli di previsione non sono ancora capaci di “digerirli”.

Che tu sappia, ci sono altri sistemi simili aria – terra già operativi?

Per il volo a vela utilizziamo già sistemi locali ( es. Centro Italia) di previsione “RASP” a griglie molto strette (1500 metri) per 12-36 ore e devo dire che negli ultimi anni i progressi reali sono sorprendenti: oggi partiamo per un volo con delle indicazioni più che attendibili sulle coperture, intensità delle correnti verticali e linee di convergenza – a luglio durante un volo Rieti – Matera – Rieti le intensità, posizioni e orari delle brezze marine adriatiche furono previste in modo straordinario, permettendo lunghi tratti a quota costante e velocità tra 150 e 200 km/h.

Mi ha sempre meravigliato, per tutti questi modelli, la loro attuale incapacità di usare dati sparsi aggiornati in tempo reale – abbiamo circa 10.000 aerei in volo che per ogni decollo e atterraggio potrebbero fornire dei datapoints atmosferici precisi dal terreno fino a 10.000 metri e trasmetterli in tempo reale, ma i modelli attuali non sembrano capaci di utilizzare questi dati sparsi nello spazio e nel tempo per riconciliare i dati calcolati con quelli reali.

Ci arriveranno di sicuro nel prossimo futuro e dovrebbero finalmente poter consentire la previsione a sei – dodici ore del “temporale su Fiuggi alle 16 e 15”, oggi ancora impossibile.

Carissimo Alvaro,

Le osservazioni da aeromobile sono già assimilate e sono anche di buona qualità.

Sul temporale delle 16:15 non sarei così sicuro.

gg

Guido, io ovviamente all'”altro campo” pensavo… 🙂

Decida Guido se questo commento è in topic…

IBM ha da poco annunciato la disponibilità del suo primo computer a quanti commerciale:

https://www.extremetech.com/extreme/283427-quantum-computing-goes-commercial-with-ibms-q-system-one

Mi chiedo se potrà giocare un ruolo nelle previsioni meteo. Tuttavia mi chiedo anche se – riallacciandomi al commento di Guido – non ci troveremo con una sovrabbondanza di potenza di calcolo in relazione ai dati disponibili, nonché ai modelli, e se questo non “ispirerà” qualcuno a fare ulteriori danni…

Fabrizio, ho visto e letto del lancio di IBM. Certamente si sta spingendo sulla potenza di calcolo, almeno sul piano tecnologico e IBM fa il suo mestiere. È pur vero, come ha commentato anche Donato, che il lato scientifico è altrettanto importante e in questo anche l’NCAR fa il suo. Come del resto l’ECMWF, che lancerà tra un paio d’anni un global model non idrostatico a 5km.

Nel campo meteorologico non vedo danni possibili, perché la verifica è troppo immediata e gli scopi sono troppo pragmatici… nell’altro campo, bè, avremo GCM a 1000 anni e ad alta risoluzione, in grado di dirti come cambierà il clima del tuo giardino, ma non ci sarà nessuno a verificarlo. 😉

“Ora, tutte queste novità, suscitano però anche qualche dubbio.”

.

Molti dubbi, ad essere sinceri.

Il primo dubbio riguarda la comprensione della fisica del sistema. Siamo veramente sicuri di aver compreso bene e di saperla modellare, la convezione umida? Fino a tre o quattro anni fa, sembrava di no. Se negli ultimi anni mi fosse sfuggito qualcosa, sarei grato di fare ammenda, ma non mi risulta che abbiamo migliorato il nostro grado di comprensione del fenomeno.

.

Altro aspetto che mi lascia perplesso, riguarda la modellazione delle nuvole. Anche in questo caso non mi sembra che siamo delle aquile, per cui possiamo scendere anche a griglie di 3 metri, ma se non sappiamo bene come si formano le nubi e come esse determinino il flusso energetico, mi sa che facciamo un bel buco nell’acqua.

.

Un modello per funzionare al meglio richiede la conoscenza dei valori dei parametri nei nodi della griglia su cui esso è basato. Solo in questo modo la soluzione delle equazioni fluidodinamiche e termodinamiche che costituiscono il modello, sono in grado di descriverlo efficacemente. Mano mano che rendiamo più fitte le maglie della griglia aumentiamo il numero di dati da inserire nel sistema. Se non disponiamo dei dati, dobbiamo inventarceli, pardon determinarli per interpolazione. E a questo punto tutta l’accuratezza del modello va a farsi friggere.

.

Ed il particolato e gli aerosol, come li modelliamo, visto che i dati in nostro possesso sono piuttosto “evanescenti”?

Onestamente mi sentirei di consigliare maggiori investimenti sulla comprensione della fisica del sistema e poi passare ai modelli più sofisticati come quelli indicati nel post. Probabilmente, però, IBM (che credo finanzi tutto il progetto) ha altri interessi da portare avanti e, quindi, va bene così: il clima o il tempo e la loro previsione di questi tempi sono un ottimo viatico. 🙂

E poi sono anni che ci dicono che la scienza del clima è “settled” per cui maggiori investimenti sulla fisica di base sarebbero inutili. O no?

Ciao, Donato.