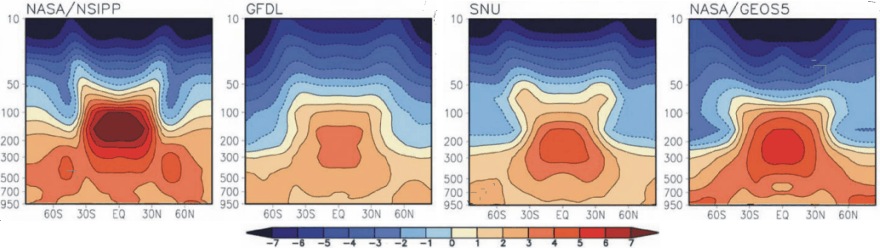

Per i non addetti ai lavori. L’hot spot troposferico è, ma è meglio dire dovrebbe essere, un anomalo riscaldamento della media e altra troposfera intertropicale di cui si trova ampia conferma nelle simulazioni climatiche ma di cui, sin qui, nessuno ha mai trovato traccia nelle osservazioni. Il suo rinvenimento, qualora confermato, validando i modelli, sarebbe al contempo l’impronta digitale delle origini antropiche del global warming. Questo sotto è il risultato della simulazione del comportamento della troposfera per un raddoppio della concentrazione di CO2, come da Lee et al. 2007 in cui è evidente l’aumento della temperatura negli strati medio alti per le latitudini intertropicali.

Questo argomento lo abbiamo trattato già più volte, non starò qui a ripetere, piuttosto preferisco riportare quanto scritto in un post del 2012 (qui e qui i precedenti):

| Nella fascia intertropicale (fra 30°N e 30°S) ad un aumento della temperatura in superficie (indotto ad esempio da un incremento della radiazione ad onda lunga del cielo e cioè dell’effetto serra) dovrebbe corrispondere all’equilibrio un aumento circa doppio nella media troposfera (a 4000-6000 m di quota) e circa triplo nella troposfera medio-alta (a 7000-9000 m di quota). Questo è un dover essere per il sistema climatico che si chiama conservazione del gradiente pseudo-adiabatico nella zona di pertinenza della cella di Hadley. Si tenga infatti presente che la salita delle massa d’aria nella cella di Hadley, da cui dipende l’intero meccanismo di scambio latitudinale dell’energia fra equatore e poli, è legato al sussistere di condizioni di instabilità potenziale che si reggono sulla presenza nella troposfera di un gradiente pseudo-adiabatico.Il profilo altitudinale del gradiente pseudo-adiabatico è tale per cui, a fronte di un riscaldamento x in superficie si dovrebbe assistere ad un riscaldamento pari a 2x nella media troposfera e 3x nella troposfera medio – alta. Tale riscaldamento dovrebbe essere osservato dagli strumenti di misura e simulato dai modelli (sia misure sia modelli dovrebbero dovrebbero ovviamente rispondere con un certo delay, necessario al sistema per mettersi in equilibrio rispetto al riscaldamento al suolo). |

Ora, dopo cinque report IPCC e anni di analisi e ricerca in cui dai dati osservati non era stato possibile tirar fuori alcun segnale dell’esistenza dell’hot spot, è uscito un nuovo paper in cui gli autori dichiarano che dopo attenta analisi e opportuna rivisitazione statistica delle serie disponibili, il riscaldamento sarebbe lì, in bella evidenza.

Questa sotto è la figura chiave del loro articolo in cui è impossibile negare la similarità con quanto visto più su, cioè con le simulazioni climatiche.

Ma, c’è un problema, o meglio, più d’uno.

Come spiegato poco più su, ad un riscaldamento della media e altra troposfera deve corrispondere un riscaldamento in superficie, che invece, specie negli ultimi 15 anni, è del tutto assente (dati MSU-RSS da climate4you.com).

Per cui, cerca che ti ricerca, stira i dati di qua e stirali di là, hanno trovato qualcosa che secondo le leggi della termodinamica, cui sono soggetti ovviamente anche i modelli di simulazione, semplicemente non può esistere. Senza riscaldamento in superficie, infatti non è possibile che si sia scaldata la troposfera. Che infatti non lo ha fatto, come dimostrano piuttosto chiaramente i dati in quota che non sono passati attraverso la ‘revisione’ operata in questo studio.

Da notare che nella figura proveniente dal paper il riscaldamento più accentuato è proprio a 200hPa, cioè a 12km circa di altezza.

Tornerei a ripetere quanto già scritto anni fa nei post linkati più su: in un mondo normale dovrebbero essere le simulazioni a cambiare per rispecchiare fedelmente la realtà, non il contrario.

NB: per chi volesse, la storia è anche su Science Daily.

L’articolo originale è liberamente accessibile:

http://iopscience.iop.org/1748-9326/10/5/054007/article

per cui ho potuto iniziare a leggerlo.

A prima vista ci troviamo di fronte alla solita minestra: i dati sono disomogenei per cui si rende necessario omogeneizzarli e, dove mancano del tutto, ricostruirli sulla base dei dati di stazioni “vicine”. Si è provveduto, inoltre, a “correggere” i dati sbagliati. Il fulcro di tutto il discorso è stato quello di individuare i cosiddetti change-point, cioè i punti in cui si sono avute variazioni dello strumento o della metodologia di misurazione. A partire da tali punti sono stati introdotti dei coefficienti correttivi che hanno consentito di determinare l’errore sistematico delle misurazioni (rispetto alle vecchie o alle nuove) e, quindi, determinare il set di dati riveduto e corretto. Il tutto mediante un massiccio uso di tecniche statistiche molto sofisticate in grado di operare su insiemi di dati piuttosto degradati e lacunosi.

.

Questo a seguito di una lettura piuttosto superficiale e frettolosa. Ho intenzione di approfondire (compatibilmente con la disponibilità di tempo) la questione per cui, probabilmente, ritornerò sull’argomento.

Per ora mi limito a riportare la mia impressione iniziale: il set di dati dopo il “trattamento” è completamente diverso da quello originario. La statistica ha creato delle “misure sintetiche” che poco o nulla hanno a che vedere con quelle reali: hanno trovato, infatti, ciò che prima non esisteva.

Ciao, Donato.

Mi chiedo che senso abbia rivisitare i dati (in una discussione precedente con Donato ho appreso della “lisciatura” dei dati per togliere il “rumore” -oscillazioni ad alta frequenza) se non si conosce il funzionamento del sistema che li genera. Urano e Nettuno, se non ricordo male, sono stati trovati grazie ad un “modello” abbastanza buono (per non parlare di onde elettromagnetiche ed antimateria). Le rivisitazioni statistiche che vengono fatte che giustificazioni hanno?Altra considerazione: il riscaldamento c’è stato fino 2000; poi si vedono gli effetti nella troposfera nel 2012 (si parla di delay…)…

Per contestualizzare appieno l’informazione fornita da Guido evidenzio che:

1. la fisica di base indica che l’incremento di temperatura indotto da CO2 è stimabile in +1°C passando dai livelli pre-industriali (280 ppmv) al valore atteso grossomodo per il 2050 (560 ppmv) (stima effettuata applicando l’equazione di Mihre – IPCC, 2001 – e la legge di Stefan – Boltzmann)

2,. La teoria AGW considera tre principali feed-back positivi in grado di amplificare il modesto effetto termico di CO2 e cioè: feedback da vapore acqueo, feedback da copertura nuvolosa e feedback da conservazione del gradiente pseudo-adiabatico.

Il feedback da vapore acqueo (VA) potrebbe anche starci in quanto VA è di gran lunga il principale gas serra e inoltre sappiamo che a parità di umidità relativa il contenuto in vapore di una massa d’aria (umidità specifica) raddoppia per ogni 10°C di incremento della temperatura. Aggiungo però come elemento problematico che in realtà l’atmosfera si libera con relativa facilità dell’eccesso di vapore acqueo tramite la pioggia (come ad esempio accade alla fine di ogni El Nino quando si entra nella fase di la Nina) evitando così che il pianeta vada incontro ad un rovinoso runaway greenhouse effect (http://en.wikipedia.org/wiki/Runaway_greenhouse_effect).

Il feedback da nubi è tutto da dimostrare in quanto le nubi sono fra le entità più elusive e recalcitranti alla modellizzazione che esistano nella nostra atmosfera

Resta il feedback da gradiente pseudo-adiabatico e ciò spiega l’ansia di osservare l’hot-spot in modo tale da eliminare una rilevante eccezione alla teoria AGW.