Non è detto che debba o possa mantenere le sue prestazioni il modello climatico messo su dal Global Warming Prediction Project, perché chi lo ha costruito ci tiene a specificare che si tratta di un modello pensato per il breve e medio termine climatico, tipicamente la scala decadale. Ma per ora le prestazioni sono eccellenti, molto più di quanto non riescano a fare i modelli impiegati dall’IPCC per redigere ad esempio il report del 2007.

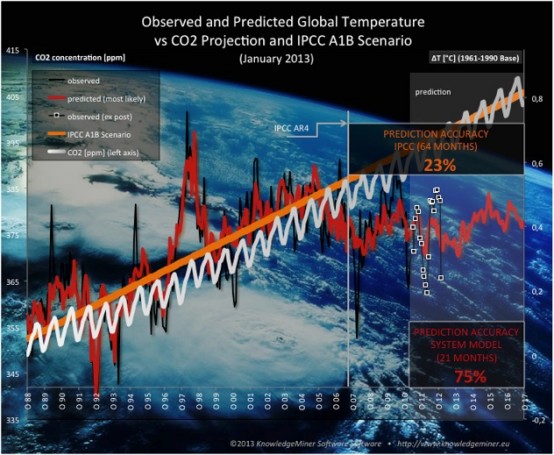

La figura in testa a questo post è piuttosto eloquente, la curva delle temperature medie globali “prevista” all’inizio del progetto è sorprendentemente vicina a quella dei dati osservati i quali, ma questo lo sappiamo già, continuano inesorabilmente ad allontanarsi da quelli che ci saremmo dovuti aspettare secondo gli scenari “ufficiali”.

A questo link, c’è una pagina che spiega a grandi linee l’approccio utilizzato. Gli autori sottolinenano che il loro modello non è CO2 dipendente, benché la variabile anidride carbonica sia comunque tenuta in considerazione. Con questa però lo sono anche la concentrazione dell’ozono, gli Aerosol, la nuvolosità e le temperature globali in qualità di variabili endogene, mentre l’attività solare, ovvero le macchie solari, è trattata come variabile esogena al sistema.

Quel che mi ha più incuriosito, oltre naturalmente l’accuratezza della previsione che comunque è relativa ad un periodo che climaticamente non ha molto significato, è la presenza di concetti come i driver climatici cosmici, da loro identificati nell’Oscillazione dell’orbita della Terra, il ciclo multidecadale tri-sinodico Giove/Saturno e il ciclo dell’eccentricità dell’orbita di Milankovitch.

Ora, un modello climatico è normalmente costruito per il lungo termine, quindi non necessariamente deve essere affidabile per il breve e medio termine, anzi, l’elisioni delle oscillazioni ad alta frequenza sono è una caratteristica tipica dei modelli qualitativi per il lungo termine. Però la difficoltà nel seguire l’andamento a stretta scala temporale, specie se espressa sempre con lo stesso segno che per quel che riguarda i modelli IPCC è una importante sovrastima, può essere indice di un progressivo allontamento di quel modello dalla capacità descrittiva del complesso dei meccanismi che regolano il sistema. E questo non è affatto tipico per nessun tipo di modello, specie se questo allontanamento è del tutto assente per i periodi di test, ovvero per le ricostruzioni del passato e si presenta così prepotentemente quando inizia il periodo in cui il modello deve “camminare da solo”. Evidentemente, la relazione univoca su cui si fondano le proiezioni IPCC più CO2 più temperatura, non è in grado di seguire l’andamento del sistema.

Ad oggi non è dato sapere se questo approccio differente, fondato come leggiamo sulle loro pagine su metodi di estrazione della conoscenza dalle informazioni tipici dei modelli a reti neurali, reggerà il confronto con il futuro nel medio e lungo termine, vedremo. Curiosamente però la loro previsione di assenza di trend positivo almeno fino alla fine di questa decade coincide con quella dell’Hadley Centre di cui abbiamo parlato qualche settimana fa. Certo sarà dura continuare a parlare di arrosto climatico…

Ho esitato molto a postare un commento, alla fine mi sono deciso. Le polemiche mi sono un poco antipatiche per cui preferirei non entrarci. Comunque, visto che ci siamo, vorrei dare un piccolo contributo nella speranza di smussare qualche spigolo. 🙂

Stiamo esaminando un grafico in cui, più che l’aspetto quantitativo del riscaldamento al 2017/2020 che tanto appassiona i nostri interlocutori “indiretti”, bisogna guardare l’aspetto qualitativo del problema: ad un aumento continuo delle emissioni di CO2 (secondo il peggiore degli scenari IPCC), le temperature globali aumentano con un rateo inferiore agli scenari migliori dell’IPCC. Questa stasi che ormai sembra assodata a quasi tutti i livelli del dibattito, potrebbe essere temporanea o definitiva. Secondo la linea di pensiero dominante la stasi è temporanea, secondo altre linee di pensiero la cosa è indice di quella variabilità naturale che negli ambienti scettici trova maggiore consenso. Personalmente sono scettico su entrambe le posizioni: aspetto tempi più lunghi (sperando di poterci arrivare 🙂 ) in quanto gli intervalli temporali messi a confronto sono troppo diversi per poter esprimere un giudizio definitivo: dieci, dodici, quindici anni sono troppo pochi per essere confrontati in modo efficace con tempi secolari. Quantificare decimi di grado in più o in meno al 2020 è un puro esercizio di stile che può solo sollecitare la vis polemica di qualcuno (come desumo dalle citazioni di C. Costa). Quel che conta, e in questo concordo con agrimensore, è che è stato individuato un modello con tecnologia basata sulle reti neurali che riesce a replicare il passato e che si adatta piuttosto bene ai dati rilevati. Potrebbe essere un effetto di “tuning”, ma non è giusto porre limiti alle possibilità del sistema. Sarebbe opportuno, come per tante altre cose, aspettare che nuovi dati riescano a confermare o smentire la bontà del modello: chi vivrà, vedrà. Un piccolo dubbio a proposito di tuning, mi viene dalla constatazione che il sistema riesca a replicare anche l’eruzione del Pinatubo che, evidentemente, esula dallo scenario statistico su cui è basato il modello.

Ciao, Donato.

Donato, forse non è così strano il caso della replica dei dati delle T dopo l’eruzione del Pinatubo se prendi in esame aerosol, optical thickness, ecc.

A posteriori non è strano in quanto il dato dell’aerosol del periodo posso inserirlo nel sistema. Il problema sorge, però, per il fututo. Una nuova eruzione, infatti, non può essere prevista da nessun modello per cui in presenza di un evento simile tutti gli scenari andrebbero a farsi benedire. Poiché gli aerosol dipendono molto anche dalle eruzioni vulcaniche, tenerne conto diventa estremamente difficile in quanto ci troviamo di fronte a dati che poco hanno a che fare con la statistica. In altre parole modellare l’aerosol mi sembra un’impresa piuttosto difficile se non impossibile. Sono idee, personali, ovviamente, per cui se gli autori sono riusciti ad individuare un algoritmo che consente di risolvere il problema, tanto di cappello.

Personalmente resto sempre dell’idea che il sistema climatico sia un sistema caotico regolato da attrattori che gli consentono di restare nello spazio delle fasi in condizioni di equilibrio dinamico e che è difficilissimo da modellare (almeno allo stato dell’arte).

Ciao, Donato.

@ Agrimensore

queste le critiche Steph scrive

“oltre alle bufale sulle false proiezioni IPCC che ormai neanche Pinocchio si beve più”L’errore sta nell’esagerazione con la quale rappresentano la proiezione dello scenario A1B dell’AR4: nell’originale (linea nera: media delle singole realizzazioni, ensemble) si prevede un aumento di 0.6 gradi C al 2020 rispetto alla media standard utilizzata (1980-1999), nel sito citato invece piazzano uno scarto di 0.8 gradi C al 2017. Un’esagerazione di almeno 1/3 ma che – estrapolata al al 2020 – potrebbe anche superare il 40%! . Voluta? Penso sì, a meno che non abbiano utilizzato un singolo run, ma allora andrebbe detto e spiegato il motivo.

Ho verificato e in effetti la proiezione sembra più la b del 2001 http://www.ipcc.ch/ipccreports/tar/wg1/figts-22.htm che dell’AR4 come dicono

la Coyaud scrive:

“confrontano 21 mesi con 64 ritagliati da una proiezione al 2100 troncata nel 2017 che già fa ridere.

E gli “errori” si vedono a occhio nudo nella fig. 2 che vi piace tanto ( avoi di CM) . Sulla stessa scala, sono incollate medie da mensili a pluridecennali. A voi (di CM) sembra confermare un ciclo “tri-sinodico” di 1.650 anni – il che fa ridere ancora di più.”

cosa ne pensi?

Sinceramente, che le proiezioni IPCC di aumento delle T siano esagerate rispetto a quello che poi è veramente avvenuto a me pare chiaro. Poi si potrà dire che il periodo di osservazione non è sufficiente, che si rimane comunque nei due sigma, ecc., ma discutere su questo temo sia improduttivo, nel senso che le distanze dei punti di vista sono troppo ampie. Magari la pendenza della retta prevista sarà pure minore (vedi tu quanti C/decade erano previsti) ma il discorso non cambia. Per il resto delle risate, direi che il problema più grande di questo sw è che ha una capacità predittiva persino troppo buona, per non spingerci a indagare su eventuale overfitting (es.: numero di nodi nel layer nascosto). D’altra parte, proprio per questo, per il limitato numero di variabili e per il fatto che non abbia utilizzato leggi della fisica, direi che allo stesso modo ci dovrebbe spingere a indagare su overfitting e eventuli bias di variabili omesse per i GCM attuali.

@ guido

ma certo ci sono entrambi sia antropici sia naturali, quindi considerano solo i naturali? e gli antropici?

@ Guido

sono Steph Agustoni e la Coyaud su Oca sapiens, ma questo non è importante puoi per cortesia chiarire a me.

come fanno ad essere variabili endogene T ozono e aerosol?

Ma perché, ti risulta che l’Ozono e gli aerosol (non antropici) vengano dalla luna?

gg

Scusami Claudio, ho capito solo ora che si tratta degli avicoli. In fondo la faccenda mi rassicura, perché in realtà penso che un paragone con le proiezioni su un periodo così breve non abbia molto senso, la temperatura media superficiale non può fare salti mortali in pochi mesi. Il fatto che dall’aia si sia deciso di starnazzare significa che la faccenda invece da’ fastidio. E poi era tanto che non ci dedicavano attenzione, sebbene ne comprenda la ragione. La causa del disastro climatico prossimo venturo riscuote sempre meno successo e trovare argomenti non è semplice, così piuttosto che tamburellare con le dita sui tavoli nell’attesa preferiscono farlo sulla tastiera e il risultato è quello che è.

gg

alcune domande scaturite da critiche (piuttosto ironiche)

Oca e steph scrivono: Scrive:”notare le false proiezioni IPCC”

Steph scrive “oltre alle bufale sulle false proiezioni IPCC che ormai neanche Pinocchio si beve più”

Perchè sono false?in fig 2 citano la proiezioni di A1B scenario (quello più probabile) è quello arancione e si vede bene qui

http://www.cics.uvic.ca/scenarios/index.cgi?More_Info-Emissions

trovo che sia riportato correttamente, dove sarebbe l’errore?

Steph scrive: “Per es. il fatto che considerino Ozone concentration e aerosols come variabili endogene del sistema, contro tutto ciò che fisica dell’atmosfera, dinamica dei fluidi, analisi dei sistemi complessi etc etc ci dicono”

la frase di Guidi è questa

“A questo link, c’è una pagina che spiega a grandi linee l’approccio utilizzato. Gli autori sottolinenano che il loro modello non è CO2 dipendente, benché la variabile anidride carbonica sia comunque tenuta in considerazione. Con questa però lo sono anche la concentrazione dell’ozono, gli Aerosol, la nuvolosità e le temperature globali in qualità di variabili endogene”

Anch’io non capisco, forse la variabile endogena riguarda solo le variazioni naturali dlele T?

Claudio, mi dispiace, ma non conosco né le persone né i commenti né le aree web a cui fai riferimento. Se hanno interesse a commentare possono farlo qui.

gg

Claudio, personalmente non direi che sono confidente che con questo approccio si possa tirare fuori un sistema che “funzioni”, come non mi sentirei di dire il contrario. E’ un sistema a reti neurali e tra l’altro non sappiamo bene (o almeno io non l’ho trovato) come si sviluppa il layer “nascosto”. Però mi pare sia importante il fatto che con le variabili in gioco sia riuscito a replicare bene l’andamento delle T totali: questo significa che non è una condizione sufficiente per affermare che un modello funzioni. E’ un punto dell’AGW che mi ha sempre lasciato perplesso, tanto è vero che parecchio tempo fa chiesi proprio se qualcuno aveva provato a implementare un modello statistico, intendendo una cosa del genere. Sul fatto che aerosol e livello di ozono siano input esterni indipendenti dall’andamento degli altri parametri che identificano lo stato del sistema, prima di esprimermi vorrei capire meglio come è stata costruita la rete neurale e, di conseguenza, in che senso è sono stati identificati come variabili endogene.

Knowledge Miner Software? LOL.

Finalmente! E’ da molto tempo che cercavo un lavoro del genere. Indipendemente dalla sua capacità predeittiva questo modello, basato su un data mining, ha dimostrato una cosa importante: il fatto di riuscire a riprodurre, più o meno bene, le temperature del secolo scorso non è affatto una prova che il modello abbia implementato tutte le variabili e leggi fisiche necessarie per effettuare delle previsioni accettabili. Tanto è vero che ci riesce anche un modello che non implementa leggi fisiche e un numero limitato di variabili. Tra l’altro ci riesce meglio, molto meglio, di quelli attuali basati su leggi fisiche. Anche solo guardando il grafico, si nota che segue le variazioni della temperatura (la temperatura ricostruita cresce quando effettivamente quella osservata cresce, e viceversa, le discrepanze al più sono sulle ampiezze).

“concetti come i driver climatici cosmici, da loro identificati nell’Oscillazione dell’orbita della Terra, il ciclo multidecadale tri-sinodico Giove/Saturno e il ciclo dell’eccentricità dell’orbita di Milankovitch.”

finalmente qualcuno li mette in discussione !