Qualche tempo fa uno dei nostri lettori ha fatto una domanda apparentemente banale ma invece piuttosto densa di significato. Si parlava di dati grezzi e dati omogeneizzati, ossia di informazioni raccolte normalmente dalle varie fonti disponibili e poi ‘adattate’ per poter essere gestite. Nella fattispecie si parlava anche di modelli climatici, argomento che non discuteremo oggi. Piuttosto torniamo alle osservazioni.

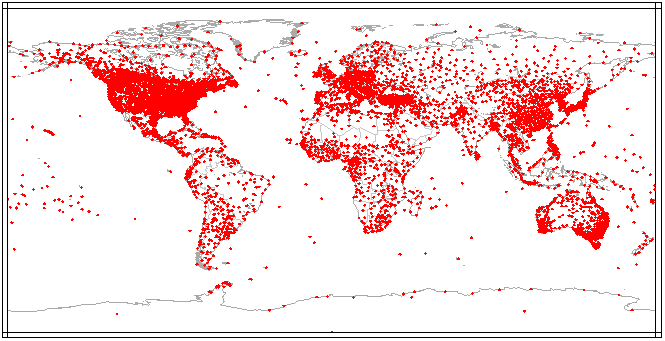

Come molti sanno, la distribuzione sul territorio dei punti di osservazione, ossia di strumenti che misurino i parametri atmosferici è molto disomogenea. Nel tempo sono stati infatti privilegiati una molteplicità di fattori, molto spesso di scarso o nullo valore in termini di attendibilità dell’informazione, requisito quest’ultimo che è invece ovviamente di primaria importanza quando i dati vengono archiviati e successivamente analizzati a scopo climatico. Tra questi fattori condizionanti, spicca naturalmente l’opportunità logistica. Una stazione vicina o addirittura inserita in un’area urbana è certamente molto più gestibile di una in mezzo al deserto o sul picco di una montagna. Ci sono poi attività umane per le quali sin da quando sono iniziate è stato necessario il monitoraggio delle condizioni atmosferiche, prima tra tutte l’attività di volo, sia essa militare o civile. Negli ultimi anni si sono poi moltiplicate le località di misura ai fini idrogeologici, di sicurezza del territorio, di funzionamento delle centrali idrolelettriche, di sicurezza della circolazione stradale etc etc. Tutte cose importanti, ma tutte cose spesso limitanti per la rappresentatività areale e temporale delle informazioni sullo stato dello strato atmosferico prossimo alla superficie.

Tutti questi dati, che naturalmente in passato erano molto meno densi, devono comunque essere corretti e omogenizzati. Perché i punti di osservazione possono cambiare e se cambiano le condizioni al contorno cambia il significato dei dati, perché inevitabilmente cambia la strumentazione e si introducono margini di errore diversi da strumento a strumento, etc etc. Va da se, quindi, che il lavoro di ‘pulizia’ dei dati sia veramente improbo. Ma è anche un lavoro ad elevato rischio di compromissione del contenuto specifico dell’informazione, ossia la variazione nel lungo periodo, il trend.

Quando si sente dire “il mondo si è scaldato” si deve tenere ben presente che si parla di una variazione della temperatura media superficiale globale di 0,7-0,8°C, un valore paragonabile alla sensibilità degli strumenti utilizzati in passato e solo di poco superiore alla sensibilità degli strumenti attuali. Attenzione, è chiaro che il termometro digitale di ultima generazione può arrivare facilmente sotto il decimo di grado, ma qui si sta parlando di dati raccolti in giro per il mondo con standard necessariamente molto, ma molto meno precisi.

In molte altre occasioni, ci è capitato di dire che la temperatura media superficiale globale non è di fatto misurata ma stimata, come parimenti si stima e non si misura il suo trend.

Le ricostruzioni, le analisi, gli studi su questo argomento non si contano. L’ultimo sforzo, ad esempio e’ quello del BEST, progetto di ricerca che si e’ posto l’obbiettivo di valutare se e quanto i diversi dataset di temperatura disponibili differiscano e siano effettivamente rappresentativi di quanto è accaduto da quando si è iniziato a misurare oggettivamente il parametro temperatura.

In effetti, tra questi dataset l’accordo è molto buono, le differenze sono minime e riguardano soprattutto il passo di griglia con cui i dati sono rappresentati e le scelte di inserire o meno nel computo quelle porzioni di territorio per cui le informazioni disponibili sono decisamente scarse o del tutto assenti. Il GISS della NASA, ad esempio, accetta di ritenere rappresentative per l’area artica delle informazioni che coprano aree pari fino a 1200km, mentre la Climatic Research Unit inglese è più prudente e le zone artiche preferisce non inserirle affatto.

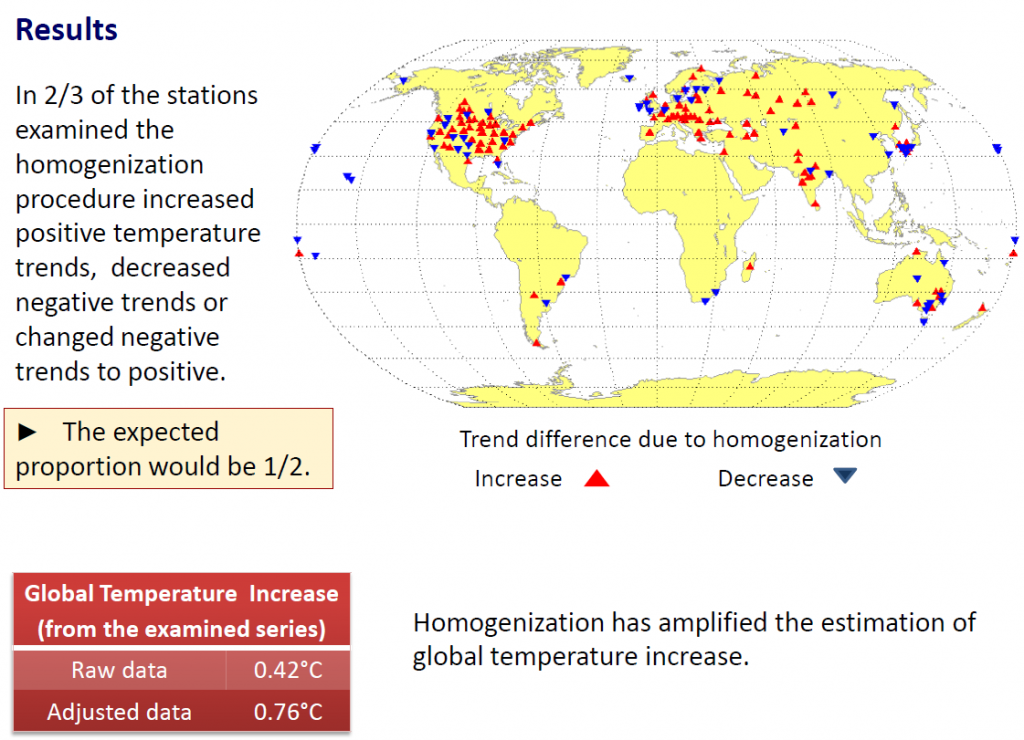

Tutti però, ma proprio tutti devono necessariamente trattare i dati. E così, alcuni ricercatori, hanno deciso di valutare dal punto di vista statistico e procedurale queste tecniche di omogeneizzazione. Ne è venuto fuori che su un campione di poco meno di 200 serie di dati, le procedure di aggiustamento dei dati grezzi hanno, in oltre i 2/3 dei casi, riscaldato i dati caldi o raffreddato quelli freddi, quando non si è trattato proprio di inversione del trend, che da negativo è divenuto positivo, cioè di riscaldamento.

Investigation of methods for hydroclimatic data homogenization

La figura in testa a questo post riassume i risultati del loro lavoro.

Cosa significa tutto ciò? Nei loro calcoli, significa che l’aumento della temperatura media superficiale globale dal 1850 ad oggi, non è stato di 0.7-0.8°C, ma e’ stato compreso tra 0.4 e 0.7 gradi centigradi, con consistente probabilità di essere più prossimo al limite inferiore di questo range. Quasi meta’ del global warming, dunque, sarebbe frutto di procedure di trattamento dei dati potenzialmente errate o comunque condizionanti al punto di rendere i dati non più rappresentativi.

Procedure che gli autori dicono essere il più delle volte meramente statistiche e spesso non supportate da metadata, ossia da descrizioni delle variazioni intercorse nel tempo alle serie che indicano la direzione nella quale deve andare la correzione, frutto quindi di scelte arbitrarie o comunque non fondate su valutazioni di carattere atmosferico, meteorologico o climatico.

Un bel sasso nello stagno, anzi, per restare in tema, uno tsunami che, se confermato – e c’è da scommettere che si sentiranno ruggire le bocche da fuoco del mainstream scientifico dell’AGW – ridimensiona non poco il problema o quanto meno riconduce ad un livello molto più scientifico e molto meno mediatico, le certezze e le incertezze che abbiamo in materia di evoluzione delle temperature.

Staremo a vedere.

Qui il pdf della loro presentazione.

…e un’ultima cosa…..miseria come sono contento che siano dei greci ad aver fatto questo lavoro!!!!!!!!!!

scusate non avevo ancora visto il pdf che conferma la predominanza del bias caldo….anche perche’ bastava solo aver studiato termodinamica per capirlo

Pielke ha da tempo dimostrato l’effetto suolo sui metodi di omogeneizzazione e ha proposto un sistema basato sulle reanalisi che liberano dopo 2 o 3 run i dati da questo effetto. Omogeneizzare con maglia variabile e’ un task ancora non poco affidabile in termini di controllo dei cambiamenti dell’uso del suolo. Molte delle stazioni della mappa hanno un quality assurance estremamente dubbia. Non e’ vero che una serie statistica di temperatura le code di errore si eliminino perche’ predomina il bias caldo. Tutti problemi evidenziati da molto, molto tempo…se non ne facciamo piu’ una religione e’ possibile risolverlo: personalmente credo che risolverlo significhi dimenticarsi per buona parte dell’AGW perche’ ci resta solo un pezzetto di GW e su quello non si fa una grande politica ne cambiamento di modello di sviluppo, cosi’ scatterebbe indietro in agenda con dramma profondo per diverse carriere.

Ho letto il post di S. McIntyre, relativo al lavoro di D. Koutsoyiannis et al., segnalato da G. Guidi.

In buona sostanza McIntyre non esprime giudizi di merito sulla questione. Si limita a constatare che oggi fa più caldo del 19° secolo e di tanto è convinto al di là delle elucubrazioni sui metodi statistici utilizzati per omogeneizzare le serie di dati grezzi. Quello che mi è sembrato più interessante, però, sono state le considerazione che svolge lo statistico in merito agli algoritmi di omogeneizzazione e che hanno determinato un garbato scambio di opinioni tra S. McIntyre e V. Venema (tralasciando quelle degli altri commentatori, non perché poco interessanti, ma per brevità).

McIntyre, in buona sostanza, sostiene che gli algoritmi di omogeneizzazione delle temperature non sono mai stati oggetto di revisione da parte di statistici. Menne, uno dei principali autori dell’algoritmo di omogeneizzazione noto come Changepoints, a detta di McIntyre, addirittura si rifiutò di pubblicarlo. Questi algoritmi, pertanto, sono sempre stati piuttosto misteriosi. Come si può vedere da questo breve riassunto il rapporto tra statistici e climatologi appare piuttosto difficile. Degna di rilievo è la considerazione che McIntyre ha dei climatologi e dei revisori delle riviste specializzate: deboli in statistica! 🙂

L’opinione di McIntyre relativa alla scarsa attenzione ai metodi empirici per l’omogeneizzazione delle serie di misure di temperature e della scarsa trasparenza delle metodologie statistiche utilizzate in alternativa ai metodi empirici, è piuttosto condivisa tra i lettori del blog di McIntyre. Non manca, però, l’aperta disapprovazione di altri lettori. Tra questi ultimi ho potuto notare le opinioni di V. Venema, autore di molti lavori relativi agli algoritmi di omogeneizzazione dei record di temperature. Egli ha opinioni diametralmente opposte a quelle di McIntyre. Secondo Venema, infatti, è piuttosto ingeneroso parlare di mancanza di verifiche empiriche e di sole metodiche statistiche nelle tecniche di omogeneizzazione. A giustifica della sua tesi ricorda che, in occasione di modifiche della strumentazione di misura, vengono eseguite, con sempre maggior frequenza, diverse serie di misurazioni in parallelo con i vecchi ed i nuovi strumenti. A questa obiezione di Venema, McIntyre replica che ciò si sta facendo grazie alle critiche che sono state mosse alle metodiche essenzialmente statistiche da esponenti del mondo scettico. Venema, comunque, sostiene che, anche nel caso l’omogeneizzazione sia stata eseguita in modo puramente matematico, studi condotti su diverse stazioni hanno consentito di accertare che le serie omogeneizzate sono più affidabili di quelle grezze in quanto l’omogeneizzazione riesce a rimuovere diversi errori (l’effetto UHI, per esempio). (Tengo a precisare che per comprendere meglio il pensiero di V. Venema, ho dato uno sguardo anche a qualche pagina del suo blog.)

Ed, infine, un piccolo cenno ai ruggiti delle bocche da fuoco di parte AGW che cominciano a scatenarsi contro la presentazione di D. Koutsoyiannis et al..

La prima bordata riguarda il fatto che si tratta di una semplice presentazione e non di un lavoro sottoposto a revisione tra pari. Questo ha scatenato una polemica al calor bianco nei riguardi di A. Watts che, pur avendo rapidamente corretto il suo post iniziale, originariamente aveva parlato di lavoro sottoposto a referaggio: apriti cielo! Gli insulti e gli improperi abbondano!

La seconda bordata è molto più subdola. Lo stesso V. Venema, nel suo blog, con riferimento alla presentazione di D. Koutsoyiannis et al., parla della comunicazione di uno studente in una conferenza. Secondo lui un errore, considerando la sede in cui è stata fatta la comunicazione e la levatura scientifica degli autori della comunicazione, è accettabile, non lo è, invece, la pervicacia con cui A. Watts si ostina a considerarla la prova degli errori degli “omogeneizzatori”. Nuova valanga di improperi contro gli scettici (pseudo-scettici, per la precisione) ed, in particolare, contro quelli che frequentano WUWT.

E, per finire, (sul serio questa volta 🙂 ) la ciliegina sulla torta. V. Venema, per prima cosa, ricorda la mole di lavori referati che può vantare sul problema dell’omogeneizzazione (della serie: lei non sa chi sono io). Successivamente, pur precisando che la presentazione è troppo stringata per consentire di accertare la bontà del lavoro di D. Koutsoyiannis et al., scrive che, a suo parere, si aspetta che i risultati illustrati nella presentazione siano sbagliati.

Mi sa che la carriera scientifica del povero D. Koutsoyiannis e quelle dei coautori della presentazione, sono finite prima ancora di cominciare! Chi tocca le torri ben munite dei sostenitori dell’AGW, muore! 🙂

Ciao, Donato.

Donato, la reazione era inevitabile e non é del tutto peregrina. Ma se non sono degli sprovveduti totali, gli autori della presentazione ne faranno scaturire un paper. E allora vedremo. Quanto alla taratura degli strumenti, quel che dici é vero, come é peró vero che se poi non si perpetuano le verifiche, la parità strumentale va a farsi benedire. É successo di recente in occasione del presunto record di caldo a Roma, con lo strumento nuovo e quello vecchio separati da diversi decimi di grado a favore del primo. Cosí si fanno i record.

gg

Mi auguro di poter leggere al più presto il paper di D. Koutsoyiannis.Non per spirito di polemica, ma per il bene della scienza.

Ciao, Donato.

dal tuo commento, Venema:

“A giustifica della sua tesi ricorda che, in occasione di modifiche della strumentazione di misura, vengono eseguite, con sempre maggior frequenza, diverse serie di misurazioni in parallelo con i vecchi ed i nuovi strumenti.”

Mi colpisce quel “con sempre maggior frequenza”. Ma come, ci sono casi in cui questo passaggio OBBLIGATORIO non viene fatto ? Ma che razza di scienziati sono quelli che cambiano metodo di misura e non comparano e tarano i metodi e le strumentazioni ?

Quando è capitato a noi di dover automatizzare delle lavorazioni, ovviamente abbiamo dedicato molto tempo proprio a questo importantissimo elemento.

Ma pare che nel mondo climatologico non sia così, se devo giudicare dal fatto che varie correzioni sono state fatte anche a distanza di decine di anni, per esempio per la sostituzione dei secchi con le boe, e non solo.

Rimango allibito quando vengo a sapere di correzioni fatte dopo così tanti anni. E mi vengono mille dubbi angosciosi.

Si, Guido hai perfettamente ragione. Dalla discussione su Climate Audit emerge chiaramente che le misurazioni in parallelo, nel passato, erano delle eccezioni. V. Venema giustifica la circostanza con il fatto che non è facile riuscire a prevedere con anni di anticipo che una certa strumentazione verrà cambiata. Mc Intyre, da parte sua, attribuisce l’intensificazione delle misurazioni in parallelo, alle critiche mosse dagli scettici alle metodologie di omogeneizzazione basate su analisi statistiche. Anche oggi, comunque, le misurazioni in parallelo, per quel che sono riuscito a capire, non costituiscono la norma e restano dei casi piuttosto isolati.

Del resto se abbiamo la statistica dalla nostra parte che necessità abbiamo di dati reali? 🙂

p.s. mi dispiace aver contribuito ad aumentare il numero di dubbi angosciosi, sappi, però, che condividere i problemi aiuta a superarli. 🙂

Ciao, Donato.

Ho letto con attenzione il lavoro di S. Koutsoyiannis et al. e, alla fine, ho tirato un sospiro di sollievo. In altre circostanze e per altri motivi, ho avuto modo di discutere delle problematiche connesse alla omogeneizzazione dei dati (le ultime occasioni sono state offerte dai post che F. Zavatti pubblica a proposito degli aggiornamenti dei dataset NOAA), ma le discussioni si sono verificate anche in altre circostanze. Io ho sempre sostenuto di essere molto perplesso circa le metodologie di omogeneizzazione delle misure grezze. In particolare mi risultava (e risulta ancora) strano che dati ormai consolidati venissero modificati sulla base di algoritmi matematici per rendere controntabili le misure attuali con quelle del passato. G. Guidi ci ricorda che questa omogeneizzazione è necessaria in quanto si ha bisogno di dati confrontabili ed omogenei per costruire un dataset. La cosa che, però, non mi quadra è la mancanza di un parametro oggettivo che possa consentire, strumento per strumento, di calcolare il coefficiente correttivo. Nelle varie discussioni mi hanno sempre ricordato che “color che sanno” operavano in modo corretto e con il consenso unanime della comunità scientifica. Della serie non ti impicciare che non capisci niente. 🙂

Oggi scopro, con estrema soddisfazione, voglio dirlo, che per non saper nè leggere e né scrivere, i miei ragionamenti non erano del tutto campati in aria. In altre parole trattare nel modo in cui si è fatto i dati grezzi, alla fine, può determinare più problemi di quanti ne risolva. Altri ricercatori, in passato, avevano visto che le serie omogeneizzate perdevano ciclicità presenti nei dati grezzi. Oggi si scopre che gli algoritmi di omogeneizzazione utilizzati sovrastimano il riscaldamento o il raffreddamento delle stazioni di misurazione e, pertanto, generano dei trend di riscaldamento che sono solo un artificio matematico e nulla hanno a che fare con la fisica. Insomma, c’è molto su cui riflettere.

Ciao, Donato.

Donato, Steve McIntyre e’ intervenuto sull’argomento. Non nello specifico di questo paper, ma nel problema dell’uso non referato di procedure statistiche sviluppate appositamente per il trattamento dei dati meteo.

http://climateaudit.org/2012/07/17/station-homogenization-as-a-statistical-procedure/#more-16449

gg

Lavoro interessantissimo e, direi ben fatto. Dubito fortemente che i gruppi che si occupano di omogenizzazione non sappiano le cose scritte. Allora o tutti barano – e non credo – oppure le cose che si dovrebbero fare sono davvero difficili. Il che riporta all’ultima frase del post di GG: bisogna ricondurre il problema in ambito scientifico e smetterla di salvare il mondo ( che significa un certo tipo di organizzazione della società; il pianeta se ne infischia) in uno scenario mediatico- politico.

Ho quasi pronto il post sull’aggiornamento dei dati noaa (il dataset di cui si parla qui) di giugno. Continuerò a produrre risultati con la speranza che prima o poi si possa capire cosa fanno davvero e farò finta che tutto sia chiaro.

Mettiamola così, tra 0.4 e 0,8 °C il riscaldamento è di sicura matrice antropica.

Io sono contento, perchè mi dimezzo anche il tasso di negazionismo! 😉

Ho sempre dubitato dell’attendibilità dei dati di temperatiura globale ricostruiti sulla base di misure raccolte in tutto il mondo ma non sempre confrontabili tra loro. Per questo, da geologo, ho sempre fatto riferimento al comportamento del nostro Pianeta per avere informazioni in merito, ed in particolare alle variazioni delle dimensioni dei ghiacciai continentali. Così, ad es., tra il 1950 e il 1975 circa, i ghiaccai alpini riprendono a espandersi (Relazione al convegno di Chieti,12 giuno 2012, di Augusta Vittoria Cerutti). Credo che questa informazione sia più attendibile delle ricostruzioni fatte sui dati raccolti con le stazioni di misura. Si veda pure un interessante articolo apparso su Geoitalia n.32 (2010) di Carlo Baroni.