Ci stiamo girando intorno da qualche giorno. L’amico Teo ha detto che studierà e, se del caso, rivedrà le sue posizioni sul peso che può aver avuto nel computo dell’aumento delle temperature medie globali l’effetto riscaldante delle aree urbanizzate. L’amico Donato si è detto tutt’altro che sorpreso, come molti altri, dalle affermazioni di base delle quattro draft presentate dal Berkeley Group. L’amico Maurizio, come sempre piuttosto disincantato, ha voluto sottolineare gli aspetti a suo dire poco corretti dell’aver provocato un battage mediatico sulle proprie conclusioni prima di averle sottoposte a revisione.

Ma il succo qual’è?

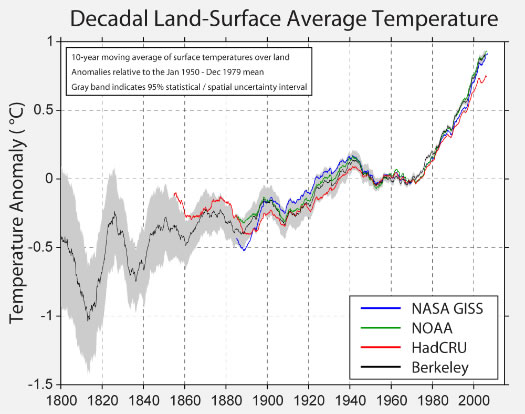

Per capirlo occorre spiegare di cosa si è sin qui occupato questo gruppo di studio. Partendo dal GHCN, il dataset di temperature medie superficiali sulle terre emerse, su cui poggia di fatto il lavoro di tutti quelli che fanno questa attività di gestione e raccolta dati, l’Hadely Centre, la NASA e la NOAA, hanno applicato delle tecniche di omogenizzazione spaziale e temporale dei dati. Tecniche che, a loro dire, permettono di utilizzare al meglio le informazioni disponibili, restituendo una serie temporale che si vorrebbe diventasse il riferimento per ogni valutazione del trend assunto da questo parametro, in passato, ma, soprattutto, in futuro.

Il lavoro è risultato essere di fatto una conferma di quanto già si sapeva, pur in un contesto di relativa incertezza per le differenze, ora più banali ora più significative, che caratterizzano le ricostruzioni che hanno preceduto questo lavoro. Questo, in teoria, non stupisce, perché i dati grezzi utilizzati sono comunque quelli che gli altri dataset condividono al 95%. E non innova, perché ai dati non se ne sono aggiunti di nuovi. Semmai, grazie appunto alle tecniche utilizzate, se ne sono utilizzati meglio alcuni, in termini di affidabilità e arricchimento delle informazioni. Però, se lo studio reggerà al confronto con la comunità scientifica, certamente aumenta il livello di confidenza circa l’evoluzione del parametro temperatura media superficiale sulle terre emerse.

E già questo lascia ampi margini di discussione, perché l’incertezza maggiore, ammesso e non concesso che la temperatura dello strato prossimo alla superficie rappresenti l’integrale del sistema, resta quella sugli oceani, a meno che non si voglia pensare di affermare che il Pianeta ha la febbre (nel senso che è più caldo di quanto dovrebbe) prendendo per buono soltanto quello che arriva da 1/3 della sua superficie. Al riguardo, quindi, c’è ancora parecchio da fare. Ma, ad ogni modo, l’informazione è in termini assoluti quanto mai importante. Chi l’ha prodotta lo sa, ma ne conosce anche i limiti.

E arriviamo al titolo di questo post.

Il leader del gruppo di ricerca ha infatti scritto un articolo sul WSJ che è di fatto la pietra tombale sull’impossibilità di avere un sano e reciprocamente rispettoso dibattito in materia di riscaldamento globale. Almeno per quel che attiene all’argomento temperature. Già, perché a sottolineare che il gruppo di studio non ha mai inteso fare alcuna valutazione sulle origini di questo riscaldamento, ci aveva già pensato prima. A quello, semmai, ci penseranno dopo o ci penserà qualcun altro, come si legge nella conclusione dell’articolo. Paradossalmente però, l’articolo voleva dire esattamente il contrario.

Ma, dicevamo, ora si può finalmente essere scettici, malgrado Richard Muller, eminente scienziato nonché leader del Berkeley Group, asserisca che sia giunto il momento di smetterla. Non è un problema. Non è difficile smettere di fare qualcosa che non si è fatto. Qualcuno ha mai negato che il mondo si sia scaldato? No. Si è discusso invece sul ‘quanto’. Lo stesso dubbio che animava il gruppo prima che si mettesse al lavoro. Lo stesso dubbio che qualcuno ha bollato come diffamazione del lavoro di onesti ricercatori. Sicché i dubbi erano e sono legittimi. Lo erano perché lo dice Muller, appena eletto salvatore della Patria dai seguaci di quelli bravi. Lo sono perché, sempre secondo le regole di quelli bravi, Muller e soci devono ancora passare le forche caudine del referaggio.

Ma non basta. Nel suo articolo Muller conferma che il gruppo che guida si è occupato delle sole terre emerse, dove 1/3 delle stazioni ha un trend negativo e 2/3 ne hanno uno positivo. La ratio 2 a 1 riflette il global warming sulla terraferma, luogo dove, egli afferma, il global warming si è sentito di più, quindi luogo di riferimento. Semaforo rosso. Non è che sulla terraferma il riscaldamento globale sia vero e sul mare no, è che sul mare non lo si è misurato come si dovrebbe. Quindi la sua confidenza nella rappresentatività delle sole terre emerse rispetto all’intero sistema è un’opinione, non un fatto. Per intenderci nulla di cui la conoscenza si possa nutrire, essendo distante anni luce dai toni scientifici dei paper appena presentati alla comunità scientifica. Almeno finché qualcuno non stabilirà che i secchi con cui si misurava la temperatura dell’acqua prima sono uguali ai termometri di ieri. E che i termometri di ieri sono uguali ai sensori satellitari di oggi. Almeno finché in questo bel campo di mele, pere e arance tutte sistemate nella stessa cassettina, qualcuno non decida di metterci dei kiwi. Salomonica scelta di frutti tipicamente privi di sapore.

A proposito di Nature Morte, un grande passo avanti del lavoro del Berkeley Group è stato quello di aver finalmente arruolato degli statistici per trattare le serie di temperatura. Bene. Che si faccia avanti il mondo di questa disciplina scientifica per giudicare il loro lavoro. Ops, è già successo e pare non vada tanto bene. Ma questo, probabilmente è solo l’inizio della solita interminabile diatriba tecnicistica sulla scelta di questa o quella tecnica statistica, di questo o quel periodo di riferimento e di analisi, di questa o quella scelta di campo.

Guardiamo al sodo. I risultati del Berkeley Group, benché provvisori, sono d’impatto. La temperatura sulla terraferma sarebbe salita dall’inizio del XIX secolo ad oggi di quasi 2°C. Mi ricorda qualcosa. Mi ricorda quei 2°C che secondo le ultime notizie da Radio Catastrofe Climatica sarebbero il limite da non superare per evitare il disfacimento del sistema. Un sistema che nei primi 2°C di riscaldamento ci ha ‘letteralmente’ coccolati accompagnando l’esplosione della civiltà umana e nei 2°C successivi ci dovrebbe invece accoppare. Mi ricorda anche che quando i dati del Berkely Group cominciano, la Piccola Età Glaciale finiva, e a quanto pare era più fredda di quanto si pensasse fin’ora. E non ricordo di aver visto illustrazioni di Carbonari italiani che circolavano con potenti SUV. Però, ancora, mi ricordano una variabilità climatica che qualcuno – sempre quelli bravi – ha negato a spada tratta, tacciando di negazionismo chi si ostinava a ricordarla.

Quanti ricordi, speriamo che non mi facciano dimenticare troppo in fretta questi nuovi interessanti sviluppi. Non vorrei smettere di essere scettico per oblio.

Che ne pensate di questo confronto tra grafici?

https://lh6.googleusercontent.com/-4Dh1Y372UOA/TqWneo5mo9I/AAAAAAAAAKQ/7Z_bkgvMt2g/s800/bestHSanim.gif

A me sembra che BEST rappresenti una pietra tombale per il bastone da hockey.

Ciao, Donato.

E’ quello che penso anch’io, diciamo, “in via preliminare”. Di sicuro però non avrà lo stesso risalto che i risultati ottenuti per gli ultimi 100 anni…

Durante una visita al sito CA di S. McIntyre e leggendo il post del 22 u.s. a firma del dr. McIntyre, ho potuto capire che il giudizio del dott. McIntyre sui risultati di BEST è globalmente positivo. In realtà McIntyre ha evidenziato qualche problema, ma riguarda dettagli di importanza marginale. Secondo McIntyre il fatto che dopo 25 anni vi sia stata un’iniezione di “forze fresche” nel mondo della climatologia, grazie al progetto BEST, è molto positivo. Il lavoro di Muller e del suo gruppo, secondo McIntyre, è molto importante anche perché getta una luce del tutto nuova sulle vicende climatiche del 19° secolo che, in base alle nuove analisi, risulta molto più freddo di quanto si pensasse. A proposito delle barre di errore, McIntyre giudica corrette le conclusioni di BEST in quanto la mole di dati disponibili per il 19° secolo (soprattutto la parte iniziale), è piuttosto ridotta. In particolare questi dati riguardano zone popolate (il nord del mondo, per intenderci) e lasciano del tutto scoperte vaste aree del globo. Secondo McIntyre in quegli anni bisogna immaginare una griglia delle stazioni di rilevamento molto più larga e molto più disomogenea di quelle attuali: la conseguenza logica è una banda di incertezza maggiore (cosa che ha fatto infuriare molti commentatori del blog di J. Curry). Il metodo di analisi statistica utilizzato (kriging) è, sempre secondo McIntyre, corretto e ben si adatta alla particolare tipologia dei dati inerenti le temperature. Altro punto importante da prendere in considerazione è la sconfessione delle tesi che mettevano in dubbio la PEG: i dati dimostrano che essa fu reale e che rappresentò un periodo veramente freddo. Con buona pace di Mann & c.

In parole povere McIntyre, con la pubblicazione dei risultati di BEST, si toglie parecchi sassolini dalle scarpe (al pari di Teo e C. Costa).

Ovviamente i risultati di BEST presentano anche diversi punti oscuri che McIntyre si riserva di analizzare con calma. Anche lui, come Teo, intende studiare. Il primo problema riguarda la tecnica di omogeneizzazione dei record di dati: nei vari paper non vengono illustrate le tecniche utilizzate. McIntyre è fiducioso che questa lacuna verrà colmata. Allo stesso modo non sono stati chiariti i dettagli dei calcoli del gruppo di Muller: anche per questi dettagli McIntyre è fiducioso in una successiva integrazione. Le critiche più forti di McIntyre al lavoro di BEST, secondo il mio modesto parere, riguardano la qualità delle stazioni. Come avevano notato tutti nei commenti di ieri qui su CM, è questo il punto debole del lavoro di BEST. In particolare McIntyre non riesce a replicare, con i dati in suo possesso, i risultati di BEST relativamente alle stazioni meteo esaminate. In particolare BEST sovrastima gli incrementi delle temperature rispetto ai risultati ottenuti da McIntyre. Stranamente, fa notare McIntyre, i dati che meglio si adattano ai risultati di BEST sono quelli delle stazioni che negli USA sono considerate di livello inferiore.

Un capitolo a parte nel post di McIntyre è dedicato alle SST. Esse, però, non sono state oggetto dell’attenzione di BEST per cui questa parte del post riguarda polemiche relative alle tecniche utilizzate per “uniformare” le SST alle temperature “terrestri”.

Un ultimo appunto McIntyre lo riserva a Nature e New Scientist: i giornalisti delle due riviste hanno male interpretato il suo pensiero ed hanno spacciato le sue critiche ad alcuni punti dei risultati di BEST per critiche da estendere a tutto il lavoro del gruppo di R. Muller.

Questo post, come si vede, non considera il lavoro di Muller e del suo gruppo una pietra tombale per le tesi scettiche. I risultati di BEST, anzi, convalidano molte delle loro perplessità e ne smontano una (la più debole, secondo me): la temperatura globale è aumentata, almeno sulla terraferma. Resta da vedere cosa succederà quando si integreranno anche le temperature sugli oceani. McIntyre ha sovrapposto un grafico delle SST al grafico BEST: mentre i due grafici combaciano, nei limiti dell’errore statistico, fino al 1980, a partire da tale epoca tendono a divergere in modo significativo. La prossima tappa sarà proprio questa, secondo me. Chiarire se questa divergenza esiste e perché.

Una considerazione finale: tutto questo è stato fatto perché gli scettici hanno avanzato delle critiche al lavoro dei climatologi; perché i blogger hanno messo in dubbio le certezze granitiche dei “detentori della verità” e la revisione tra pari. Si vede, quindi, che gli scettici, in fondo in fondo, non avevano tutti i torti. Quindi, parafrasando il titolo del post, scettici eravate e scettici dovete restare: è utile alla scienza.

Ciao, Donato.

Reply

Appunto. Grazie Donato.

gg

Ecco un altro grafico (da Real-Science). Tutto quello di cui parliamo, e’ dentro il piccolo cerchio verde.

C’è una risposta di Lindzen a Muller

http://www.climatedepot.com/a/13403/MITs-Richard-Lindzen–Physicist-David-Douglass-Mullers-findings-of-warming-arenothing-remarkable–BEST-study-does-not-alter-Climategates-serious-breaches-of-ethics

in cui, tra l’altro, dice:

[ While Muller carefully avoided any claims concerning attribution, even attribution is not the main issue. What was left unsaid was that the observed warming is entirely consistent with there being very little problem. Concerns focus on climate sensitivity. Some current models predict much more warming than the modest warming that increasing CO2 would result in. This is because water vapor and clouds (both far more important greenhouse substances than CO2) in these models act as powerful positive feedbacks. Such models can be brought into agreement with past behavior by invoking aerosols. But, as the IPCC acknowledges, these are essentially unknown, and, indeed, each modeling group chooses a different value according to the amount of warming they need to cancel. ]

in sintesi vapor acqueo e nuvole sono rappresentate nei modelli come potenti feedback positivi, e i modelli vengono fatti adattare a certi andamenti del passato invocando gli aerosol, ma, dato che sono essenzialmente sconosciuti, ogni gruppo di modellazione sceglie un valore diverso a seconda della quantità di riscaldamento che debbono cancellare.

Lindzen fa anche notare come Muller non parli della distinzione tra riscaldamento “attivo” (e cioè causato dall’attività dell’uomo) e “passivo” (quello naturale). Personalmente penso che questa sia una distinzione mancante che crea spesso fraintendimenti nel pubblico, perché ben diverso è pensare ad una naturale evoluzione della temperatura, che di suo, da che mondo è mondo, va su e giù, ed anche di molto. E molto di più dei due gradi alla quale dovremmo essere capaci, secondo l’IPCC, di incatenare il clima frenando le emissioni di CO2…

e diverso è che sia l’attività umana a causare un (presunto) pericolo, sulla cui reale consistenza giganteggia solo il “principio” di precauzione, e la triste circostanza che gli scienziati hanno dichiarato di non trovare un giusto colpevole, pur avendo confessato di non saperne abbastanza di nuvolosità, raggi cosmici e via dicendo (non sapere = sicura innocenza ?), senza contare il ruolo del Sole, sulla cui conoscenza è illuminante (nel caso del sole è doveroso dirlo 🙂 ) la quantità di previsioni sbagliate fatte sull’ultimo ciclo…

Ma oltre a queste possibili cause ancora incerte, sollevate da ambienti scettici, possiamo escludere che il vero (presunto) killer del nostro pianeta non si nasconda in qualcosa di ancora non conosciuto, o conosciuto ma sottostimato ?

Tempo fa fu notato che l’andamento del GW si correlava meglio con l’andamento delle supernovae, che con l’andamento della CO2, per esempio (scusate la forma assai terra-terra colla quale mi esprimo, ma lo fo ad usum delphini, ed anche perché son figlio di Cicerone e del suo Antonio nel “De oratore”).

Non voglio dire che sia così… non fraintendetemi, lungi da me aspirare a premi nobel o solenni ramanzine, ma intendo solo dire che la mancanza di altre spiegazioni NON può essere portata come la madre delle prove, la prova regina, quella che non ammette altra interpretazione….cioè l’ignoranza (detto con tutto il rispetto, e in riferimento all’argomento e non certo alle degnissime e preparatissime persone che hanno sollevato questo argomento) NON può essere un punto di forza in un ragionamento !

Secondo me.

Lo scetticismo e’ un ferro del mestiere per il ricercatore, il fideismo lo e’ per il religioso. Scettico sono e scettico moriro’, pero’ spero non sempre sugli stessi argomenti altrimenti sarebbe noia mortale. Verso la fine degli anni ’90 mi imbatto in un lavoro di Hughes che mi fa vedere la differenza di temperatura media per citta’ e campagna in Australia. Provo a ricostruire con i dati a me disponibili e trovo una conferma delle deduzioni di Hughes. Perche’ l’Australia? perche’ li sicuramente la questione di lana caprina se siamo in rural o urban e’ molto secca: o ci sei o non ci sei. Aggiungendo che dalle stesse fonti IPCC emerge che sono la massime notturne a pesare sul dato mi sembra che l’ipotesi urbanizzazione (che sempre antropica e’) possa di fatto inquinare la cosiddetta temperatura globale. Inoltre, usando proprio luci della Terra uno si accorge che l’immagine e’ quasi direttamente sovrapponibile a quella della rete di stazioni GHCN. Un piu’ tardo lavoro di Pielke et al. mette il dito sul fatto che il sistema di omogeneizzazione dei dati alla Hansen (una sorta di media tra le stazioni piu’ vicine su una maglia irregolare, quindi media statisticamente variabile in significativita’) possa enfatizzare gli eventuali effetti di cambiamento dell’uso del suolo (sempre antropici ma non CO2) e propone per evitare questi effetti di utilizzare le reanalisi a quota piu’ elevata cosi’ da far perdere memoria al sistema proprio di questo effetto LUC.

Fino ad oggi, a parte qualche ‘tanto non pesa nulla’ o ‘vuoi mai dire che ci sbagliamo tutti?’ o ‘stiamo faticando a prendere questi dati e voi a criticare’ (ho alcune foto interessanti dove anch’io rischio la pellaccia per prendere misure quindi non facciamo troppo gli unici ad essere sofferenti ed incompresi), dicevo fino ad oggi non avevo ancora sentito qualcuno che considerasse gli elementi per cui sono scettico su questo argomento.

Permettetemi un liberatorio ‘BEN VENGA!’ per uno studio che non liquida le mie critiche, che ritengo essere fisicissime, con una scrollatina di spalle ma che anzi le consideri quantomeno tanto ragionevoli da avere dedicato risorse (che che ovviamente non potevo certo avere io che facevo critiche stupide) per mettere a punto un sistema che e’ dichiarato essere: indipendente-verificabile-inclusivo! Lasciatemi dire che se si e’ scomodato un gruppettino di nomi come quello di Berkeley per dare una risposta alle mie domande (dichiarandole peraltro ragionevoli) secondo voi non dovrei essere contento? Altro che aria di smobilitazione per me e’ una festa! Anche perche’ adesso sono altri a dover spiegare perche’ questa necessita’, sempre prospettata, non era stata tenuta in considerazione. Ma questa, perdonate, e’ una parte della mia storia personale.

Sulla scienza: lo studio dovrebbe fornire elementi per comprendere se i dati di temperatura sono ‘inquinati’ dall’effetto UHI usando pero’ un data set piu’ vasto. Gia’ mi sembra un buon risultato rispetto alla scienza. Mi rendo conto che e’ poca cosa rispetto ai miracoli della fede.

Pero’ intanto cerchiamo di capire questo.

Comunque studiero’

Scusate ho dimenticato le fonti, ma come e’ mio costume le metto:

Stefano Caserini, 2008: A qualcuno piace caldo. pp. 243-246. Edizioni Ambiente

Ben detto.

Ciao, Donato.

“Inoltre, usando proprio luci della Terra uno si accorge che l’immagine e’ quasi direttamente sovrapponibile a quella della rete di stazioni GHCN.”

E’ praticamente impossibile che le T di queste stazioni non siano state influenzate da fattori non climatici. Forse li hanno smussati, ma che non si dica che il problema non esiste.

Sulla use land o meglio sulle modifiche della T dovute alla modifica (antropica) del suolo anch’io mi voglio togliere un sassolino.

Tempo fa su meteonetwork fui pesantemente insultato (anche da Steph) e poi censurato ( meteonetwork è un centro di […] serrista) perchè ipotizzavo che i ghiacciai nel medioevo fossero più estesi di adesso anche nel caso in cui le T adesso fossero uguali, perchè:

– nel medioevo non c’era il particolato (aerosol black carbon che si deposita sulle nevi e sul ghiaccio abbassandone l’albedo, e riducendo quindi la massa del ghiacciaio)

– e perchè nel medioevo la pianura padana era ricca di boschi e zone paludose mentre ora è ricca di città e di campi coltivati e l’albedo, e l’evotrasiprazione, sono enormemente diversi tra la pianura padana di ora e quella medioevale, di conseguenza saranno state diverse le precipitazioni e le T, quindi presumibilmente anche l’estensione dei ghiacciai alpini. (ci sono peer review che dicono questo).

Eppure mi insultarono dicendo che la mia era solo spazzatura.

Può anche darsi che siano tutte stazioni “vergini” rispetto agli effetti microclimatici (e gli asini volano), però perde totalmente di significato il numero di stazioni utilizzate: se ne ho 40mila, di cui 35mila “densificate” solo nelle aree più popolate e più progredite delle terre emerse, che differenza reale c’è con averne solo 10mila ben distribuite? Inoltre, sono stati fatti approfonditi esami (controllo qualità ecc.) su tali stazioni, per verificare l’attendbilità dei dati ed eventuali errori?

95% di dati in comune vuol dire che non possono avere esluso l’effetto isole di calore nelle stazioni rurali ormai urbanizzate.

Tanto per ricordare alla radio catastrofe che l’effetto isole di calore non è un opinione qua una lista di peer review

http://greatglobalwarmingswindle.co.uk/pdf/deLaat.pdf

T. J. de Laat, A. N. Maurellis “Industrial CO2 emissions as a proxy for anthropogenic influence on lower tropospheric temperature trends” (Geophysical Research Letters, Vol. 31, L05204, 2004)

http://www.knmi.nl/~laatdej/2006joc1292.pdf

A. T. J. DE LAAT* and A. N. MAURELLIS “EVIDENCE FOR INFLUENCE OF ANTHROPOGENIC SURFACE PROCESSES ON LOWER TROPOSPHERIC AND SURFACE TEMPERATURE TRENDS” INTERNATIONAL JOURNAL OF CLIMATOLOGY Int. J. Climatol. 26: 897–913 (2006)

“negli ultimi due decenni, i processi che non riguardano l’effetto dei gas serra di origine antropica ( cioè le isole di calore) hanno contribuito in maniera significativa alla variazioni di temperatura della superficie.”

http://www.nature.com/nature/journal/v453/n7195/abs/nature06982.html

Thompson, David W. J., John J. Kennedy, John M. Wallace, and Phil D. Jones. “A large discontinuity in the mid-twentieth century in observed global-mean surface temperature.” Nature 453, no. 7195 (May 29, 2008): 646-649.

http://www-eaps.mit.edu/faculty/lindzen/203_2001GL014074.pdf

LINDZEN AND GIANNITSIS: RECONCILING GLOBAL TEMPERATURE OBSERVATIONS GEOPHYSICAL RESEARCH LETTERS, VOL. 29, NO. 0, 10.1029/2001GL014074, 2002.

http://icecap.us/images/uploads/MM.JGRDec07.pdf

McKitrick, R.R. and P.J. Michaels, 2007, Quantifying the influence of anthropogenic surface processes and inhomogeneities on gridded global climate data, J. Geophys. Res. 112, D24S09, doi:10:1029/2007JD008465

“La stima del riscaldamento globale sia stata fortemente influenzata dalle isole di calore, togliendo queste influenze l’incremento di temperatura risulta simile a quello stimato nella bassa troposfera dai satelliti.”

Claudio, credo che la considerazione con cui apri il tuo commento sia estremamente interessante. Se i dati elaborati dal gruppo di Muller coincidono per il 95% con quelli elaborati dagli altri gruppi di ricerca è ovvio che molte stazioni che 50 anni fa erano “rurali” sono diventate urbane. In altri termini non abbiamo corretto l’errore connesso alle isole di calore urbano. Muller, però, in un’intervista, parlava di strumenti di calcolo che consentivano di tener conto dell’effetto isola di calore urbano e non di escludere le stazioni urbane. In merito alle disomogeneità dei record di temperatura, Muller, in un articolo sul WSJ riferisce che essi sono stati sdoppiati in due o più record proprio per tener conto della disomogeneità dei dati.

Speriamo che, alla fine, riusciremo a capire veramente cosa stà succedendo.

Ciao, Donato.

Reply

Donato, non è un discorso di coincidenza, è un discorso di disponibilità. Il GHCN è il dataset più completo, da quello ‘pescano’ tutti quanti, semplicemente perché altri dati non ce ne sono.

gg

Guido, la questione è chiara. Il mio dubbio (che è anche il mio cruccio e, forse, nel futuro diventerà la mia croce) è che il prof. Muller parlava di strumenti informatici che consentivano di tener conto dell’effetto isola di calore. Se, alla fine, si sono limitati a prendere tutti i dati dal dataset GHCN e li hanno elaborati con una delle tecniche statistiche a disposizione senza prima applicare i correttivi necessari a tener conto dell’effetto dell’urbanizzazione, possiamo dire che la montagna ha partorito il classico topolino. Ho letto qualcosa di McIntyre in proposito, ma egli, per mancanza di tempo, non ha ancora elaborato i dati di BEST. Da quello che ho capito, però, concordava con la tecnica di analisi statistica utilizzata da Muller & C. Anzi, si considera un esperto in materia perché è la stessa che si utilizza per le prospezioni minerarie. Vediamo che succede appena si avrà più materiale a disposizione.

Ciao, Donato.

Continuo a “non capire”: la banda grigia indica l’intervallo del 95% d’incertezza statistica/spaziale, ma l’errore di strumenti, misure ecc. dov’è?

Scusate, è circa una settimana che non riesco a dormire, e la mia testa è in uno stato confusionale che non mi permette di vedere nemmeno le cose più semplici, evidentemente. Infatti non capisco quel grafico.

Eppure io i grafici in genere li capivo, fino ad una settimana fa e a tante notti passate senza poter dormire decentemente. Ora però il mio cervello è bloccato, non capisco, aiutatemi….vedo una zona nera, diciamo grigia, che dovrebbe rappresentare l’incertezza (al 95%), se capisco bene, mentre dopo un certo punto in poi, questa zona, che nel tempo si fa sempre più piccola, com’è normale, visto che la tecnologia avanza e migliora, si fa talmente sottile da non essere più distinguibile dalle linee rossa, verde e blu. Ma qui entro in crisi, perché le linee sono, sì, distinte tra di loro, ma non cadono nella zona grigia, ristrettasi grazie ai mirabolanti progressi della scienza climatica, ma non capisco quale delle linee colorate sia quella giusta….perché se non c’è incertezza, vuol dire che il valore è quello vero, ma se i valori veri sono più di uno…oh, povera testa mia, o mio mal di testa che non mi permette di ragionare….quale sarà quella vera, quella senza incertezza ? Sono tutti e tre veri, senza incertezza e distinti ? E’ forse questa la conferma della teoria quantistica là dove dice che l’elettrone può stare contemporaneamente in posti diversi ? E quindi il valore esatto climatico è anch’esso tale da essere vero, e senza incertezze, e distinto in almeno tre valori diversi, ma tutti veri ? 🙂

Nel dubbio, e in attesa di una vostra illuminante risposta, da quel scettico irrimediabile che sono vado prosaicamente a mangiare.

Buon appetito !

Guido, l’intervallo di errore è riferito alla sola serie BEST (linea nera). Le altre sono gli altri dataset, messi lì per il confronto.

gg

Guido – metti anche questo grafico da WUWT in bella vista – sono i “risultati” del BEST prima del colpo con il ferro da stiro e della quasi sparizione della stima dell’errore.

L’orrore climatico (ahr ahr) non e’ mai stato cosi’ evidente…

Reply

Ho letto Maurizio. Il PR lo metterà in evidenza. Spero.

gg