La questione è complessa, lo diciamo fin da subito, tuttavia cercheremo di edulcorarla un po’ e di capire se l’ennesimo affondo contro l’Hockey stick sia fuffa o meno. Ovviamente ci stiamo riferendo all’ultimo studio, che in questi giorni è già sulla bocca di tutti: “A Statistical Analysis Of Multiple Temperature Proxies: Are Reconstructions Of Surface Temperatures Over The Last 1000 Years Reliable?”, firmato da Blakeley McShane e Abraham J. Wyner (qui il PDF).

Innanzitutto, chi sono costoro? Vero è che nel panorama delle pubblicazioni climatologiche, entrambi siano una novità, tuttavia i loro curriculum vitae sono degni di nota. McShane, in particolare, è in possesso di diversi Master in matematica e statistica, e di un PhD in statistica, ha diverse pubblicazioni p-r all’attivo, alcuni lavori presentati e altri work in progress. La maggior parte dei topic da lui trattati riguardano le analisi bayesiane (e questo è un dato importante da tenere a mente per il resto della nostra storia). Wyner, invece, ha un PhD in statistica e ha studiato a Yale e Stanford.

Una prima considerazione circa questo paper, sottoposto a review anonimo, e che verrà pubblicato su “Annals of Applied Statistics” (la redazione ci dice di avere un IF pari 2.37, classificandosi al sesto posto tra le pubblicazioni di statistica) è la generale onestà e trasparenza che emerge dall’approccio di McShane e Wyner (M&W, d’ora in poi). Vedremo più avanti il perchè.

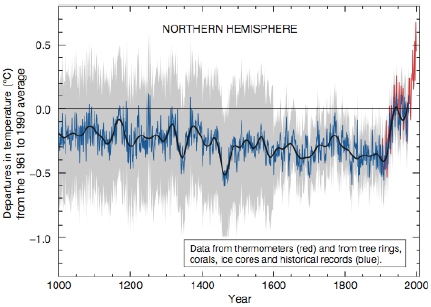

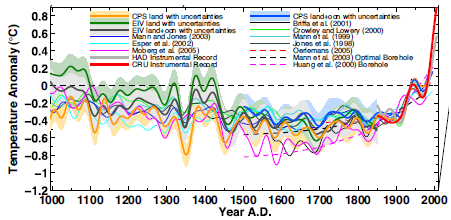

Che l’Hockey stick di Mann sia fondato su una statistica fallace è ormai risaputo da tempo. La versione del 1998, poi, era davvero imbarazzante e su questo c’è ormai una ampia letteratura (tutta correttamente citata da M&W). Talmente imbarazzante che Mann si sentì obbligato a rivedere e correggere il tutto e pubblicarne una successiva edizione nel 2008. Richiamiamo alla vostra memoria le due versioni nelle immagini successive.

Tutti sappiamo che in Mann 2008 comparve magicamente un po’ di Optimum medievale e un po’ di era glaciale, a fronte di un immutato riscaldamento nel corso del XX secolo. Questo per una parte della scienza e della politica ambientalista fu la prova provata della natura eccezionale (ed antropica) dell’attuale riscaldamento in corso. E come se ciò non bastasse, ci fu un proliferare di HS in ogni studio apparso sul globo terracqueo, che diede vita al cosiddetto consenso: se tutti gli studi mostrano un hockey stick, allora questo è vero ed esiste.

Torniamo a M&W. In realtà nel loro paper non dicono nulla di particolarmente nuovo: già McIntyre e McKitrick avevano detto molto, se non tutto.

E proprio sui proxy M&W fondano il primo assunto, ovvero che si tratti di serie storiche raccolte correttamente, secondo lo stato dell’arte. Il nostro focus non è sulla qualità dei dati, che diamo per assodata. Se già McIntyre aveva detto praticamente tutto, come mai questo nuovo studio è così interessante?

M&W utilizzano una tecnica statistica molto raffinata (che di per sè non garantisce la correttezza dell’analisi) e, inoltre, hanno il pregio di elencare con grande chiarezza tutti i problemi relativi all’analisi delle serie storiche (materia che i climatologi hanno dimostrato di conoscere poco e che, invece, è il pane quotidiano di economisti e statistici).

I proxy vengono quindi considerati tutti “buoni” e, soprattutto, vengono considerati tutti. Lo studio non si focalizza sulla dubbia pratica di Mann e altri di selezionare i proxy più accondiscententi e di scartare quelli più riottosi, per non fare torto a nessuno M&W, al contrario, li utilizzano tutti.

L’onestà scientifica di M&W si spinge oltre, ammettendo che negli ultimi 30 anni, ovvero (all’incirca 1970 – 2000) la ricostruzione derivata dai proxy è in grado di intercettare l’aumento delle temperature registrato strumentalmente.

Sono talmente trasparenti che essi stessi mettono in evidenza, a chiare lettere, quali potrebbero essere i problemi relativi alla tecnica da loro utilizzata. Va da sè che, essendo il loro studio, cerchino di “tirare l’acqua al loro mulino”, tuttavia non si nasconodo di certo dietro ai possibili problemi di natura statistica. E loro, essendo statistici, se lo possono permettere.

Vi starete chiedendo, a questo punto, di cosa stiamo parlando perchè, da un lato l’hockey stick non è così sbagliato, dall’altro lato ci presentano uno strumento che potrebbe avere dei problemi. Insomma, stiamo perdendo il nostro tempo?

Affatto.

Quello che emerge in modo chiaro è che l’incertezza insita nelle ricostruzioni proxy sia stata fino ad oggi sottovalutata. Inoltre, tale incertezza è stata sempre considerata costante nel tempo, tuttavia come hanno già fatto notare molti statistici, tale assunto è errato. In altre parole, il rapporto tra i proxy e la temperatura misurata non è costante nel tempo, essendo chiaro a tutti che le misurazioni degli ultimi decenni abbiano un margine di errore ovviamente inferiore a quello dei proxy. Questo è il motivo principale per cui, un modello tarato e funzionante sui dati recenti non può e non potrà mai restituire una ricostruzione attendibile del passato.

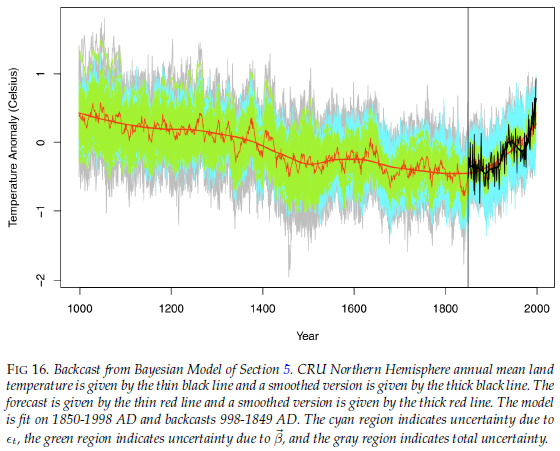

I due, quindi, costruiscono un modello, basato sulla teoria dell’inferenza bayesiana. Tale strumento è oggi sempre più utilizzato per ricostruire fenomeni del mondo fisico, tuttavia non ci addentreremo nella spiegazione di questo metodo, perchè ci porterebbe molto lontani.

Costruito il modello, ciò che ci restituisce è una ricostruzione delle temperature dell’ultimo millennio e la banda di errore dei dati. Ora, come molti siti hanno fatto, non è corretto affermare che la linea rossa (vedi immagine qui sotto) sia la temperatura dell’ultimo millennio. Soffermiamoci su questo punto: il fatto di scegliere un numero, all’interno di quella banda grigia, non è di per sè errato, tuttavia dobbiamo tenere a mente che le probabilità che sia il numero corretto sono quasi pari a zero. Viceversa abbiamo il 95% di probabilità che il numero corretto sia contenuto nella fascia grigia. Fare la media delle serie che cadono dentro quella fascia non è propriamente un esercizio edificante, ci dice molto poco e lo si fa per questioni più che altro comunicative. La psicologia dietro questa operazione è semplice: se io vedo le bande di errore e in mezzo una linea, sono portato a pensare che tutto sommato è ragionevole che quella sia la ricostruzione corretta, non recita forse il detto “in medio stat virtus”? Ecco, nel caso dell’inferenza dei proxy non è proprio così. Ogni punto all’interno di quella banda di errore ha la stessa probabilità di essere corretto.

Come se ne viene fuori? Riducendo l’incertezza nei dati, ed è l’unico modo. Fino ad allora è davvero velleitario voler proporre una ricostruzione, perchè dentro la banda di errore c’è sicuramente una curva corretta, chissà quale però, e fino a che non la si individua, sono tutte corrette allo stesso modo. Ancora più funambolico è voler utilizzare quella (tra tante) ricostruzioni per poter alimentare un modello matematico. M&S ci fanno sapere che otterremmo gli stessi risultati utilizzando una serie di dati puramente casuale.

Questo è il messaggio importante che questo studio ci consegna.

Vi sono dei problemi in M&W? Assolutamente e di alcuni ce ne danno conto gli autori stessi.

Il modello bayesiano è sicuramente una metodologia innovativa, probabilmente merita di essere analizzata e di essere sottoposta ad un vaglio più profondo.

Personalmente ritengo che uno dei problemi principali sia insito nell’utilizzo delle serie proxy emisferiche. Il problema che potrebbe emergere, così come evidenziato da alcuni, è che l’utilizzo di serie localizzate porti ad una maggiore variabilità dei dati. Su questo punto stiamo facendo i nostri ragionamenti ed, eventualmente, ne riparleremo.

Concludendo.

Possiamo dire che un nuovo argomento, importante, sia stato aggiunto alla discussione sulle ricostruzioni proxy: l’incertezza insita nei dati, fino ad oggi sottostimata. A fronte di livelli così alti di incertezza ogni ricostruzione è fittizia, l’unico dato utile dal punto di vista scientifico è la banda dell’incertezza totale.

Su alcuni siti pro-AGW, è in corso il massacro dei due, M&W. Direi che siamo nell’ambito della normale dialettica. A mio modesto parere non mi sento nella posizione di poter sottoscrivere parola per parola questo nuovo studio (i dubbi li esporrò eventualmente in un altro post), tuttavia ne colgo le grandi potenzialità e l’innovazione. Una volta per tutte è stato messo in luce il nervo scoperto della climatologia: la statistica. Al punto che lo stesso Gavin Schimdt ha affermato di voler potenziare questo settore di applicazione, stringendo legami con facoltà di statistica.

Questi i fatti, a voi la parola, ma prima, un po’ di approfondimenti:

– Inferenza bayesiana (qui)

– Autocorrelazione (qui). A proposito dell’autocorrelazione. Ho letto in giro un po’ di ironia su questo aspetto, soprattutto del fatto che M&S si lamentino dell’elevata autocorrelazione dei dati climatici. Premesso che ogni buon statistico sa sin da bambino che i dati climatici siano quasi sempre autocorrelati, soprattuto per quelle serie storiche con dati consecutivi (periodicità mensile, ad esempio), il problema è serio1 ,2 . Chi conosce la statistica sorriderà per l’ovvietà di questa affermazione, la faccio per tutti quei siti che in questo momento stanno ironizzando.

Al di là di ogni considerazione sulla metodologia statistica applicata da Mann (e falsificata dalla commissione Wegman) o da M&W (ancora sub judice, poichè in attesa di referaggio), continua a risultare per me stupefacente che stime di temperatura globale basate su cerchie di crescita degli alberi possano presentare una banda di incertezza di solo +/- 1°C. Ciò in virtù dei caratteri intrinseci di tali proxies di cui ebbi modo di discutere in un post del 5 ottobre 2009 (Dendrocronologia: Le piante non sono come il mercurio – http://www.climatemonitor.it/?p=4362).

In sintesi penso che il buon Dio avesse voluto far si che le piante fossero dei termometri le avrebbe confezionate in modo un po’ diverso da quel che sono e cioè esseri viventi dotati di un’enorme plasticità genetica e fisiologica.

Apprezzo comunque lo sforzo di M&W di avvicinarsi ad un settore tanto ideologicizzato (mi domando chi glie lo faccia fare?) e mi propongo di leggere con attenzione il loro lavoro, per cui ringrazio di cuore Claudio Gravina per averlo segnalato.

Articolo e, ovviamente, studio molto interessante.

Sono d’accordo sulle conclusioni, cioè che il punto da verificare nella scienza del clima è l’uso della statistica.

In particolare, mi piacerebbe leggere di studi analoghi su come vengono parametrizzati i GCM, magari creando un non-model a partire da puri dati climatici (senza fisica dell’atmosfera) e raffrontare le performance rispetto ai modelli più in voga.

Al di là del problema dell’incertezza che, tuttavia, è di fondamentale importanza, rispondo a chi mi scrive per posta elettronica e su FB.

M&W sono degli statistici. Essi accusano i climatologi di rivolgersi troppo poco a chi ne sa veramente di statistica. Secondo me, tuttavia, non regge l’accusa inversa di cui molti, appunto, mi scrivono. Ricordo, infatti, che M&W utilizzano gli stessi identici proxy utilizzati da Mann, ben si guardano dall’operare una selezione di questi ultimi.

CG

La critica contraria è davvero assurda: eppure una simile mentalità è piuttosto comune in ambito climatologico.

Quante volte abbiamo sentito climatologi (e non) trattare di statistica, calcolo numerico, chimica, trasmissione del calore, termodinamica, astronomia e quant’altro, spesso rigettando le tesi degli stessi esperti di questi settori (non solo l’HS, ma anche il comportamento del Sole, le bande di assorbimento dei gas serra ecc).

Semmai sarebbe vero un altro problema: gente come M&W non avrebbe gli strumenti necessari per formulare una teoria climatologica completa (la storia e l’esperienza dimostrano che nemmeno questo è di per sè vero, ma ipotizziamolo pure).

Qui però si limitano a fare dei calcoli, e nient’altro, settore in cui sono loro gli esperti: e prassi consolidata in tutti gli altri campi tecnici (chi lo perché la climatologia dovrebbe, secondo alcuni, sfuggire alle regole seguite dal resto del mondo), altrimenti i matematici ed i fisici sarebbero cronicamente disoccupati.

[…] […]

Non vedo una mazza di questo post(pagina bianca).

Ora si dovrebbe vedere tutto.

CG

Credo che l’autocorrelazione potrebbe essere usata per “pulire” i grafici di temperatura e di altri parametri dall’influenza di elementi ciclici.

Ma quando qualcuno fa qualcosa in questo senso, viene subito attaccato, chissà perché.

Secondo me.

Un veloce commento sulla banda di incertezza, da un punto di vista tecnico più che statistico.

Chiunque abbia fatto un corso di misure meccaniche e termiche ad ingegneria, dovrebbe conoscere bene i fondamenti di tale teoria.

Riassumendoli sommariamente:

– non esiste una misura come un numero “puro” e “preciso”, ma vi deve sempre essere associata una banda di incertezza;

– i valori all’interno della fascia d’incertezza, come detto, sono tutti equiprobabili, benché tale fascia possa essere calcolata con metodi statistici come una distribuzione gaussiana sulla base di una serie di dati rilevati (anche se calcolata così, non è dunque vero che la maggiore probabilità si concentra nell’intorno della linea media, e la minore sui bordi esterni);

– non esiste il concetto di uguaglianza tra misure: esso viene sostituito dal concetto di compatibilità tra le misure, laddove due misure risultano “compatibili” quando le loro fasce d’incertezza si sovrappongono (basta un punto comune, come ad esempio tra 1.2±0.1°C e 1.4±0.1°C, misure che si “toccano” a 1.3°C).

Questo spesso stride col senso comune, e con molte pubblicazioni “climatologiche” (ma forse sarebbe meglio dire proclami, come quelli sull’anno “più caldo”, misurato con differenze che invece sono ben entro la fascia d’incertezza), ma non è pura accademia: tralasciare questi punti fondamentali, oltre che gravemente errato, può portare solo a valutazioni sbagliate, per dirla in parole povere a “dare la caccia ai fantasmi”.

Per quanto può aggiungere, concordo su ogni parola. Purtroppo l’incertezza sulla misura delle grandezze meteorologiche sembra un problema rimosso: tanta statistica e poca fisica.