Tra i molti siti che trattano la modifica delle serie di temperatura osservata, mi è stato segnalato da GG Tallbloke, con un post di Roger Andrews che si riferisce ad una stazione australiana, Alice Springs, dove i dati dal 1880 al 1900 vengono raffreddati di circa 2.5 gradi rispetto alla versione GHCN 2, senza che la situazione delle stazioni vicine (siamo in Australia e il significato di “vicino” è un po’ diverso dal nostro) giustifichi queste correzioni.

La stessa NOAA mostra, per Alice Springs una correzione che produce un trend di oltre 2 gradi tra il 1880 e il 2010, a fronte di un trend osservato praticamente nullo, come appare dai tre grafici a sinistra.

Nel sito di Jo Nova l’argomento di Alice Springs viene trattato con particolare riferimento agli errori sui dati originali e alle correzioni troppo forti (sempre nel senso di accentuare il riscaldamento) fatte da ACORN (Australian Climate Observations Reference Network).

Un’analisi più accurata di una stazione islandese si può trovare qui. In particolare viene notata la scomparsa di un periodo, negli anni ’70, noto in Islanda come “Periodo del mare ghiacciato”, e se gli islandesi sentono la necessità di sottolineare un periodo particolarmente freddo … doveva essere freddo davvero!

La tendenza a raffreddare la parte iniziale del dataset e riscaldare la parte finale è piuttosto comune nella nuova versione di GHCN. Ho raccolto, in modo del tutto arbitrario, i dati NOAA di quattro stazioni da questo sito per mostrare il tipo di correzione generata dal PHA. Ovviamente chiunque può visualizzare tutte le stazioni che crede. Il primo numero dell’ID è relativo alla cartella di appartenenza.

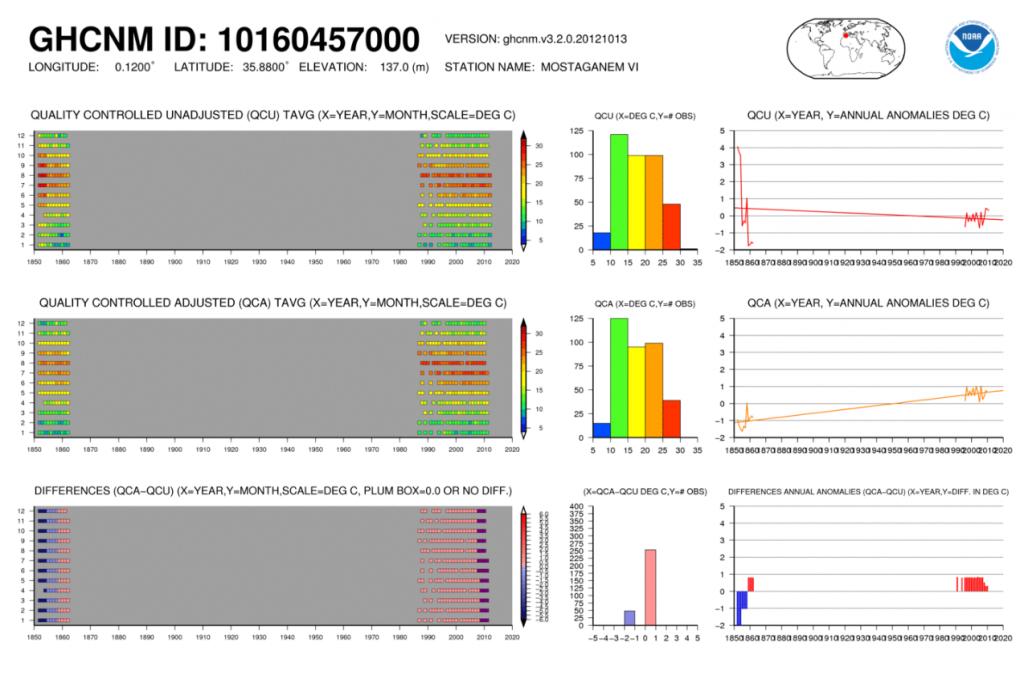

A me sembra particolarmente emblematico il caso di Mostaganem, dove la parte iniziali del dataset originale (tra il 1850 e il 1860) viene raffreddata di oltre 5 gradi, rovesciando il segno della pendenza.

A me sembra particolarmente emblematico il caso di Mostaganem, dove la parte iniziali del dataset originale (tra il 1850 e il 1860) viene raffreddata di oltre 5 gradi, rovesciando il segno della pendenza.

Il più basso dei tre grafici a sinistra di ogni immagine mostra quale parte del dataset viene raffreddata (barre blu) e di quanto. Da notare che queste correzioni riguardano le stazioni terrestri e sono a volte di 2 o 3 gradi, altre volte di decimi di grado. Quando, come qui, si usano i valori medi globali terra+oceano le correzioni si diluiscono fino ai centesimi di grado.

NB: qui e qui per i grafici delle altre due stazioni.

Ciò che secondo me non va è il criterio che regola tutta la questione dell’omogeneizzazione. Il discorso, purtroppo, è sempre lo stesso e rischio di essere ripetitivo. Questo benedetto algoritmo di omogeneizzazione non mi convince affatto. Sarò monotono, ma non riesco a mandar giù il fatto che si vadano a modificare i dati del passato in maniera meccanica senza che nessuno si prenda la briga di andare sul posto a spulciare le serie storiche ed i registri per capire se la stazione è stata modificata, se la strumentazione è migliorata o peggiorata e, soprattutto, di quanto. Sarà che sto diventando vecchio e non riesco a capire il mondo che evolve, ma l’idea di correggere da un’asettica stanza piena di computer dei dati che provengono da una località distante migliaia di chilometri mediante una formula matematica che non tiene alcun conto della storia della stazione di rilevamento, mi lascia inorridito. L’idea che un algoritmo interpreti una brusca variazione di temperatura come un errore e immediatamente applichi dei coefficienti correttivi per ridurre l’errore mi lascia interdetto. Io per mestiere misuro angoli e distanze, li inserisco in un computer che, mediante opportuni algoritmi, calcola l’errore commesso e compensa le misurazioni effettuate da me, ovviamente. Successivamente mette a confronto le mie misure con quelle di altri rilevatori e mi evidenzia gli scarti. Io, sulla base delle tolleranze previste dalla regola tecnica utilizzata, stabilisco se le mie misurazioni risultano accettabili o meno. Sia io che gli altri rilevatori, però, abbiamo misurato la stessa lunghezza anche se con strumenti ed in tempi diversi. I miei dati sono completamente confrontabili con quelli degli altri perchè i capisaldi sono rimasti gli stessi, non si sono mossi. Un errore che ecceda la tolleranza prefissata significa che le mie misurazioni o quelle dei colleghi sono sbagliate. Le rifaccio e stabilisco chi ha sbagliato. Se utilizzassi un algoritmo che confrontasse le mie misurazioni con quelle dei colleghi e modificasse le vecchie misurazioni in modo da adeguarle alle mie o viceversa io risparmierei un sacco di tempo e un sacco di lavoro, ma rischierei di smettere di lavorare: dopo tre errori di questo tipo la norma vigente prevede la sospensione dall’esercizio della professione.

Sarà per questo che io non riesco ad accettare l’idea che una serie di dati possa essere modificata da uno stupido computer sulla base di un algoritmo che opera in modo meccanico. Per il ricercatore la cosa è molto comoda (troppo, secondo me). Alcuni esperti di statistica sostengono che la cosa è lecita in quanto in molte stazioni mancano i registri e quando sono stati sostituiti gli strumenti di misura non sono state effettuate misure contemporanee con la vecchia e la nuova strumentazione per individuare l’errore sistematico dei due tipi di strumenti. Che garanzia, però, ci dà un metodo di omogeneizzazione che mette a confronto le misure di stazioni distanti anche centinaia di chilometri, e corregge quei dati che si discostano dalla media delle misurazioni senza tener in alcun conto le condizioni locali? Secondo me diamo i numeri al lotto e la dimostrazione la troviamo nel fatto che stiamo perdendo tutte le ciclicità presenti nelle serie grezze. Stiamo appiattendo ed uniformando ciò che non è nè piatto, nè uniforme. E questo non è affatto un bene per la fisica dell’atmosfera. Parere strettamente personale, ovviamente.

Ciao, Donato.

Ho notato che la situazione è un po’ diversa se si osservano i (pochi) dati della cartella 8 del sito che ho citato sopra. In alcuni casi i dati non vengono toccati dalla PHA, in altri la correzione negativa si ha al centro dell’intervallo temporale, quella positiva agli estremi. La cartella 8 sembra contenere solo dati di navi posizionate nelle zone artiche (si chiamano ship1, ship2, ecc) e non mi è sembrato di vedere i riscaldamenti che sciolgono i ghiacci polari. In un caso, con la ship C, ad un raffredamento nei dati osservati corrisponde un debole riscaldamento nei dati corretti, non in grado di sciogliere l’Artide, ma sicuramente i dati che ho visto sono molto parziali e c’è molto altro che giustifica la riduzione osservata dei ghiacci.

Alla NOAA hanno già stabilito che il 2012 sarà il più caldo di sempre, almeno per gli Stati Uniti (http://www.meteogiornale.it/notizia/24957-1-stati-uniti-inverno-caldo-e-siccitoso-parola-degli-esperti)

A me sembra di aver letto che l’incertezza sull’ENSO pone una seria ipoteca sulle previsioni stagionali. Magari hanno sbrogliato la matassa! 😉

Tanto per citare il divo Andreotti” Pensare male e’ peccato, ma in genere ci si indovina”